OpenVINO™ Workflow Consolidation Tool 教程

关于

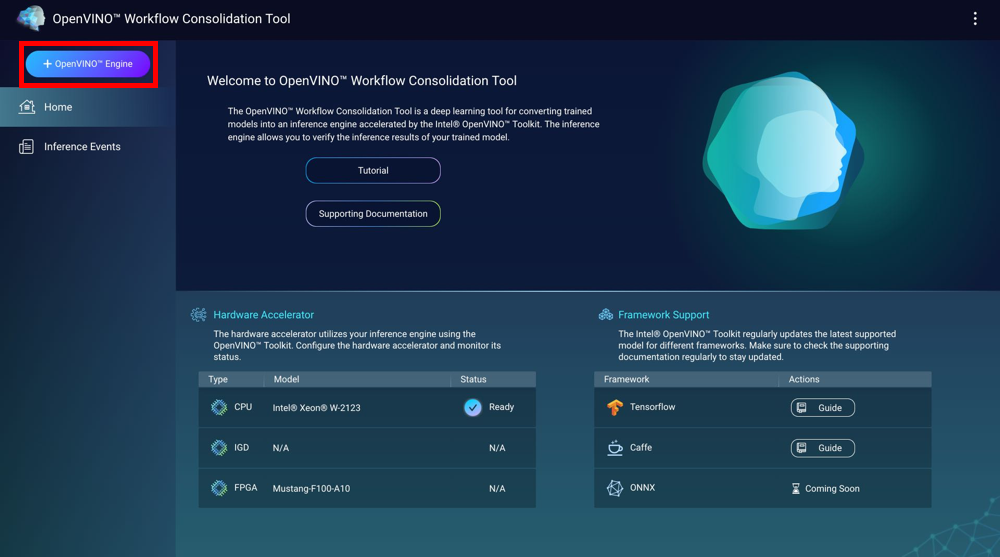

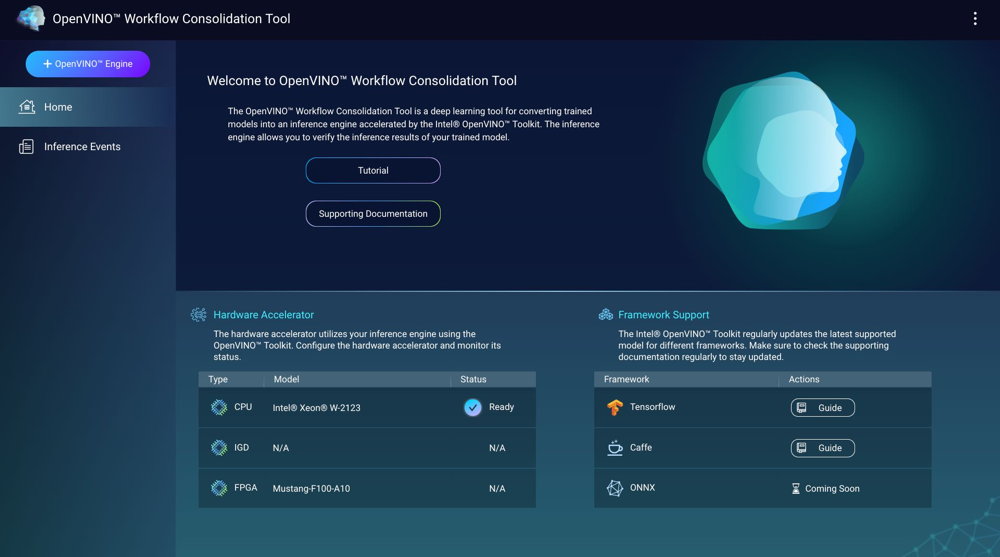

OpenVINO™ Workflow Consolidation Tool (OWCT) 是一款深度学习工具,用于将训练模型转换成由 Intel® Distribution of OpenVINO™ 工具包加速的推理引擎。通过推理引擎,您可以验证训练模型的推理结果。

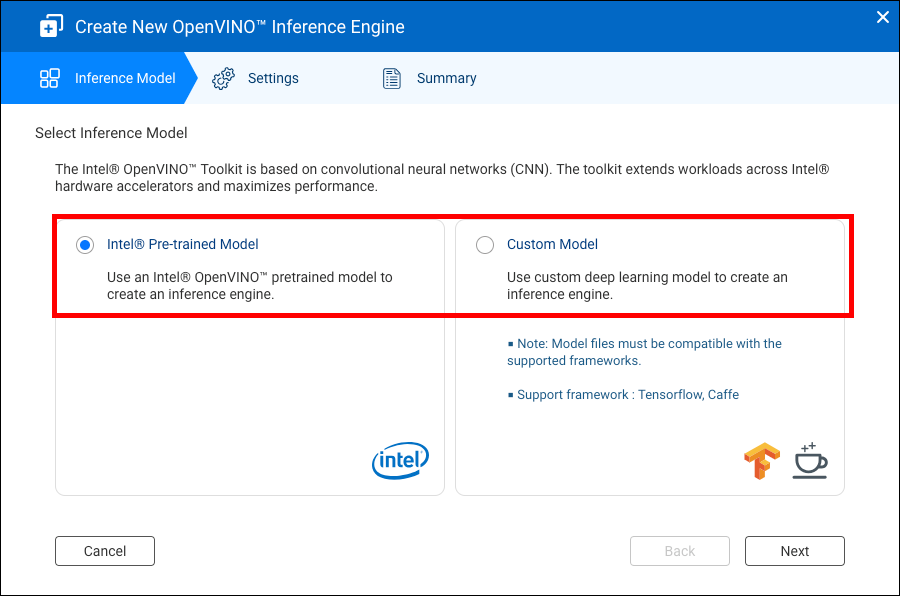

Intel® Distribution of OpenVINO™ 工具包以卷积神经网络 (Convolutional Neural Network, CNN) 为基础。该工具包将工作负载扩展到多个 Intel® 硬件加速器,从而获得最佳性能。

必须安装 Container Station 才能使用 OWCT。

兼容性

|

平台 |

支持 |

|---|---|

|

NAS 型号 |

注意:

仅基于 Intel 的 NAS 型号支持 OpenVINO™ Workflow Consolidation Tool。 |

|

操作系统 |

QTS 4.4 |

|

Intel® Distribution of OpenVINO™ 工具包版本 |

2018R5 有关详细信息,请转到 https://software.intel.com/en-us/articles/OpenVINO-RelNotes。 |

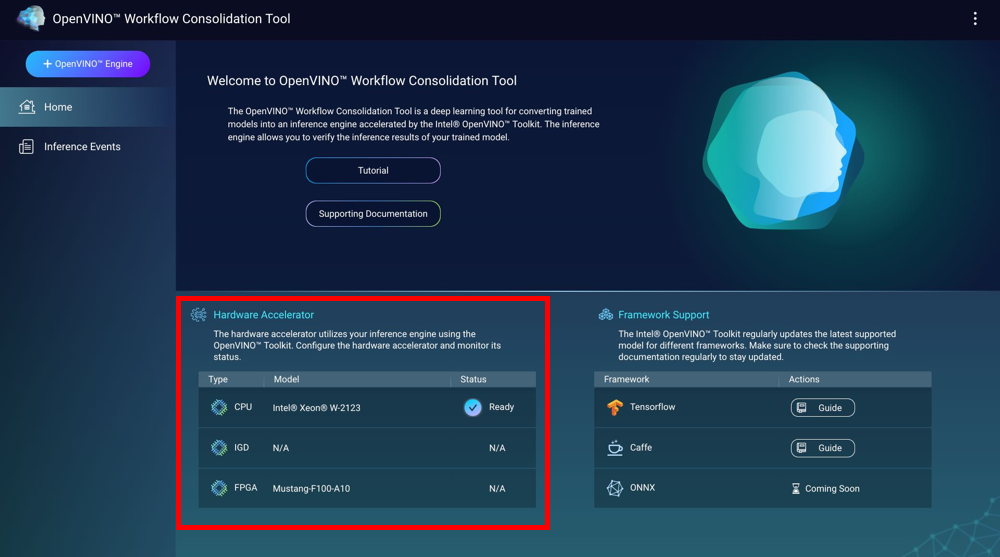

硬件加速器

您可以使用 NAS 中安装的硬件加速器来提高推理引擎的性能。

NAS 中安装的硬件加速器显示在“Home”(主页)屏幕上。

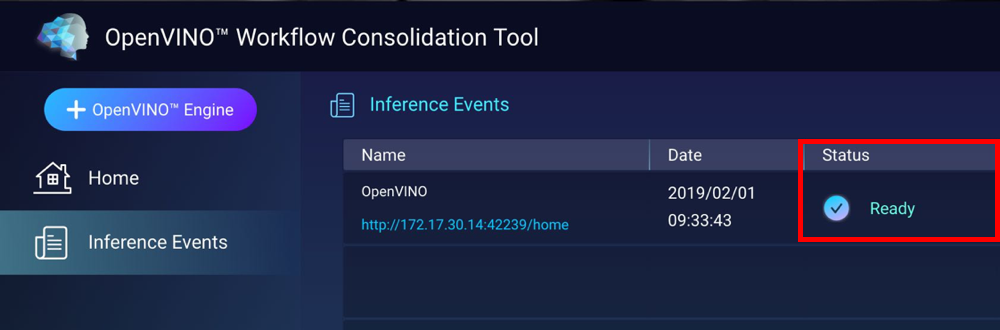

创建推理引擎时,可以使用状态为 “Ready”(就绪) 的硬件加速器。

如果显示的状态为 “Settings”(设置),请转到设置硬件加速器。

-

要在 QNAP NAS 上使用现场可编程门阵列 (FPGA) 卡,虚拟机 (Virtual Machine, VM) 直通必须处于禁用状态。

-

每个 FPGA 资源都可以创建一个推理引擎。

- 每个视觉处理单元 (Vision Processing Unit, VPU) 资源都可以创建一个推理引擎。

创建推理引擎

使用 OWCT 创建推理引擎并配置推理参数。

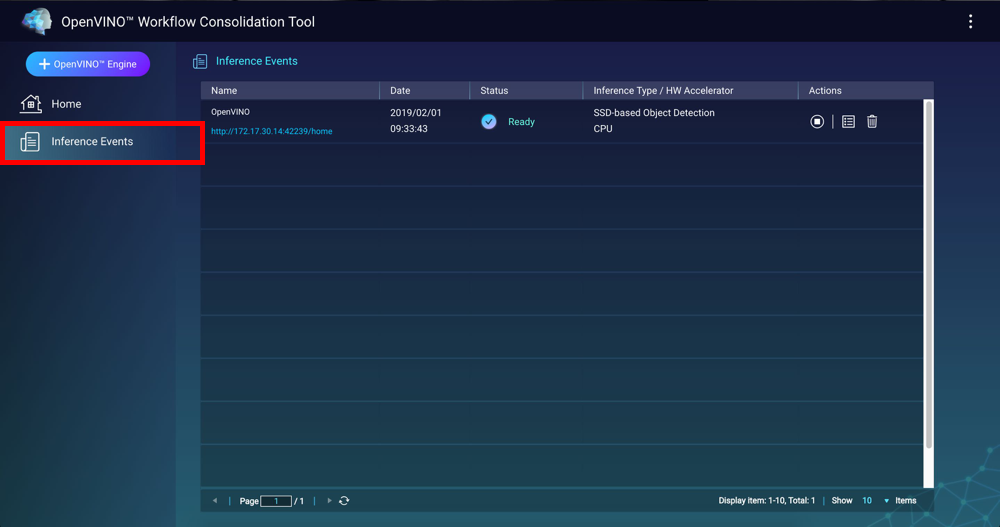

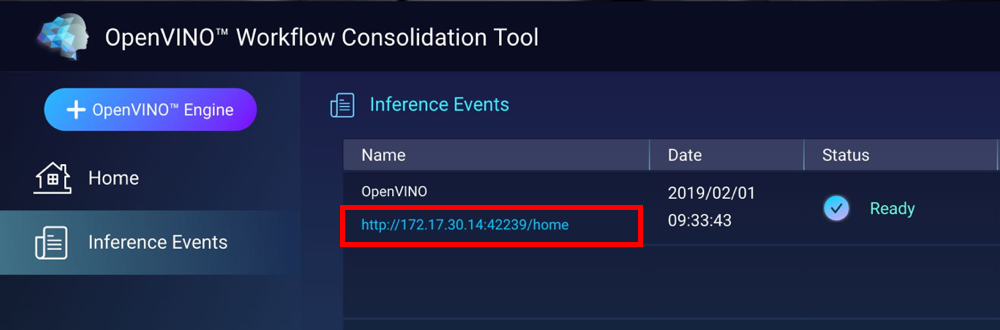

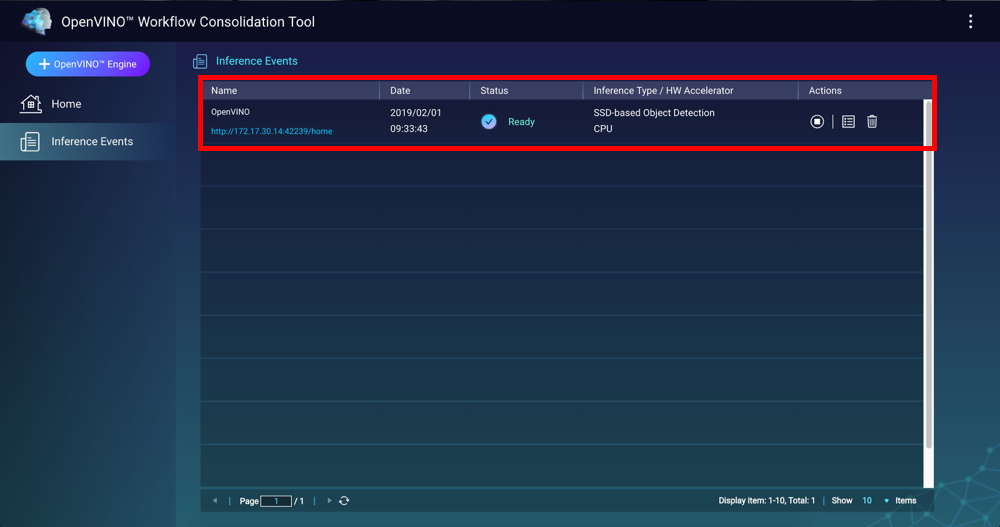

OWCT 即会创建推理引擎并将其显示在“Inference Events”(推理事件)屏幕上。

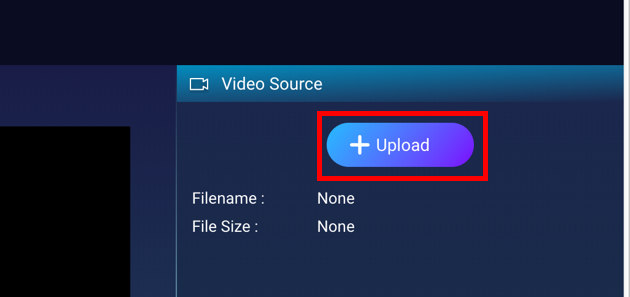

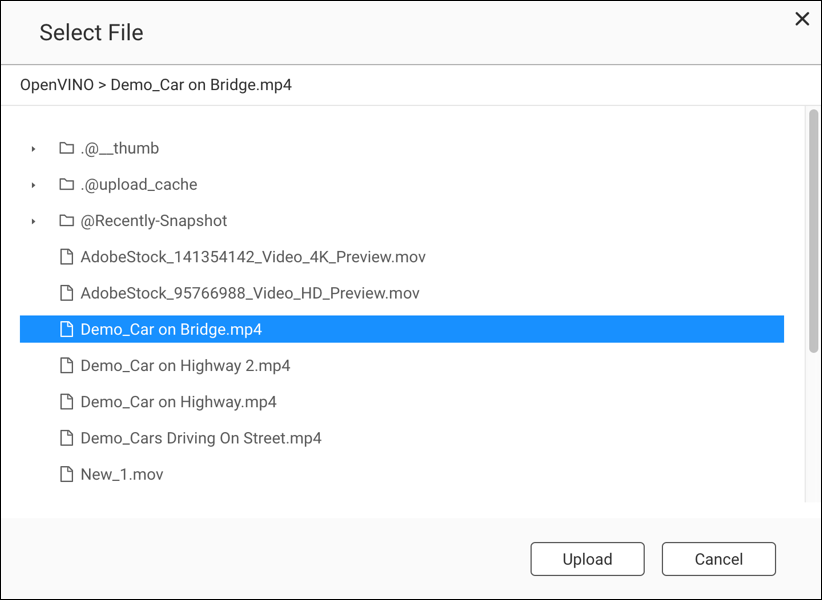

配合使用计算机视觉和推理引擎

管理推理引擎

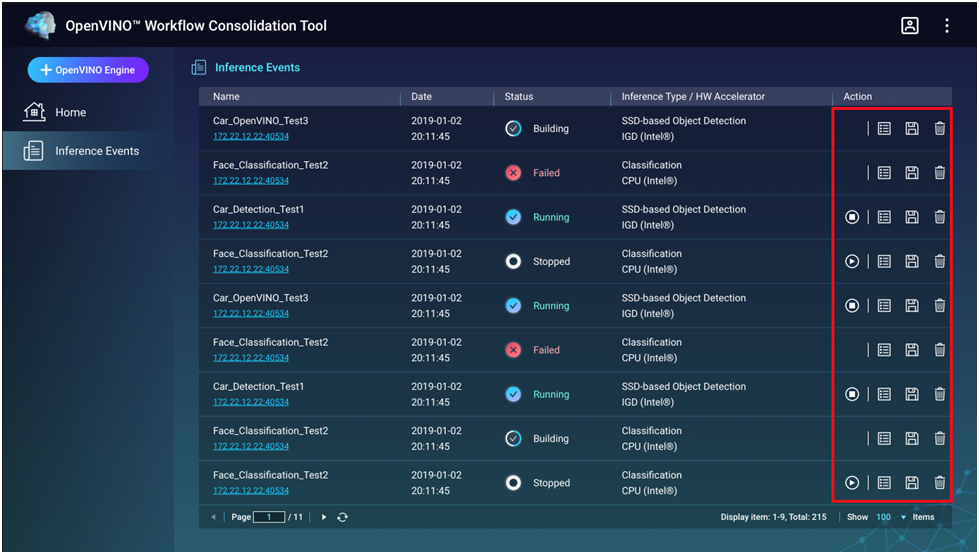

您可以在“Inference Events”(推理事件)屏幕上查看和管理推理引擎。

|

按钮 |

描述 |

|---|---|

|

|

开始推理过程。 |

|

|

停止推理过程。 |

|

|

显示推理引擎的详细信息以及日志状态。 |

|

|

将推理引擎另存为中间表示 (Intermediate Representation, IR) 文件用于高级应用。 |

|

|

删除推理引擎。 |