Applicable Products

Qsirch 6.0.0 (or later) on all platforms

Qsirch RAG Search with Cloud and On-Premise LLMs

Qsirch supports using Retrieval-Augmented Generation (RAG) with cloud-based large language models (LLMs) to deliver accurate and context-aware responses. When you enter a query, Qsirch retrieves relevant documents from your NAS and uses them as context for the language model. This combination of search and generative AI enables Qsirch to generate precise and informed answers based on your own data.

Qsirch also supports multi-turn conversation, enabling natural and context-aware interactions. Users can ask follow-up questions without repeating prior context, and context is preserved across turns for coherent answers. Multi-turn conversation support works with both cloud and on-premise RAG modes.

Integrate RAG with Cloud-based AI Services

To integrate RAG search, you must first obtain an API key from an AI service of your choice.

ChatGPT (OpenAI API)

ChatGPT (OpenAI API) provides powerful GPT models for both RAG embeddings and generative responses. Follow the steps below to apply for an API key:

- Sign up for an account on OpenAI: https://auth.openai.com/create-account

- Create an API key in the account settings.

For more information, see OpenAI API Documentation.

Azure OpenAI

Azure OpenAI provides access to OpenAI models (like GPT-4.1) via Azure infrastructure, which is ideal for enterprise solutions. Follow the steps below to apply for an API key:

- Sign in to the Azure Portal.

- Select your OpenAI resource (or create one if you do not already have one).

- On the left menu, click Keys and Endpoint.

- Copy an API key and copy the endpoint (base URL) for API requests.

For more information, see Azure OpenAI Documentation.

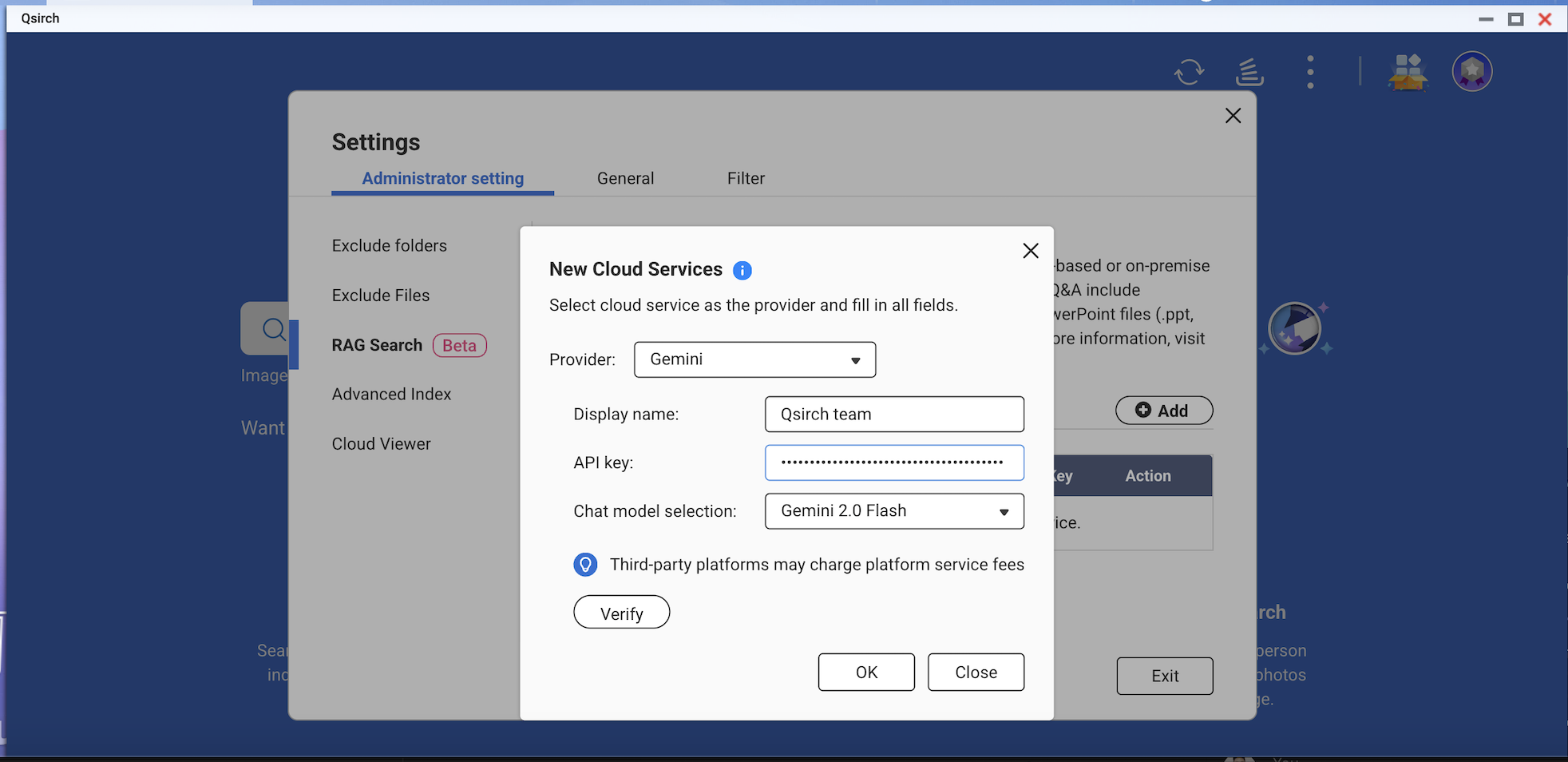

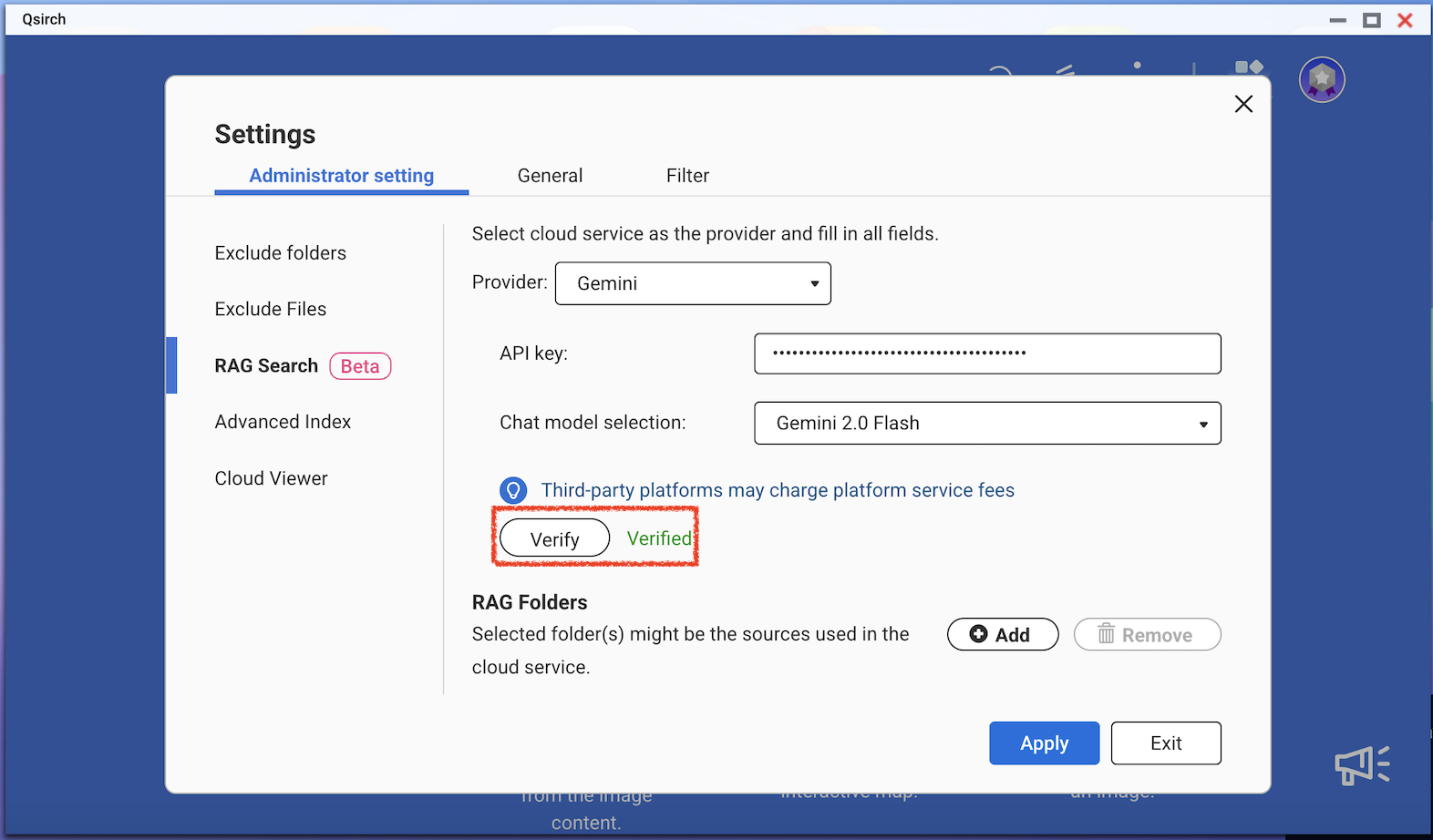

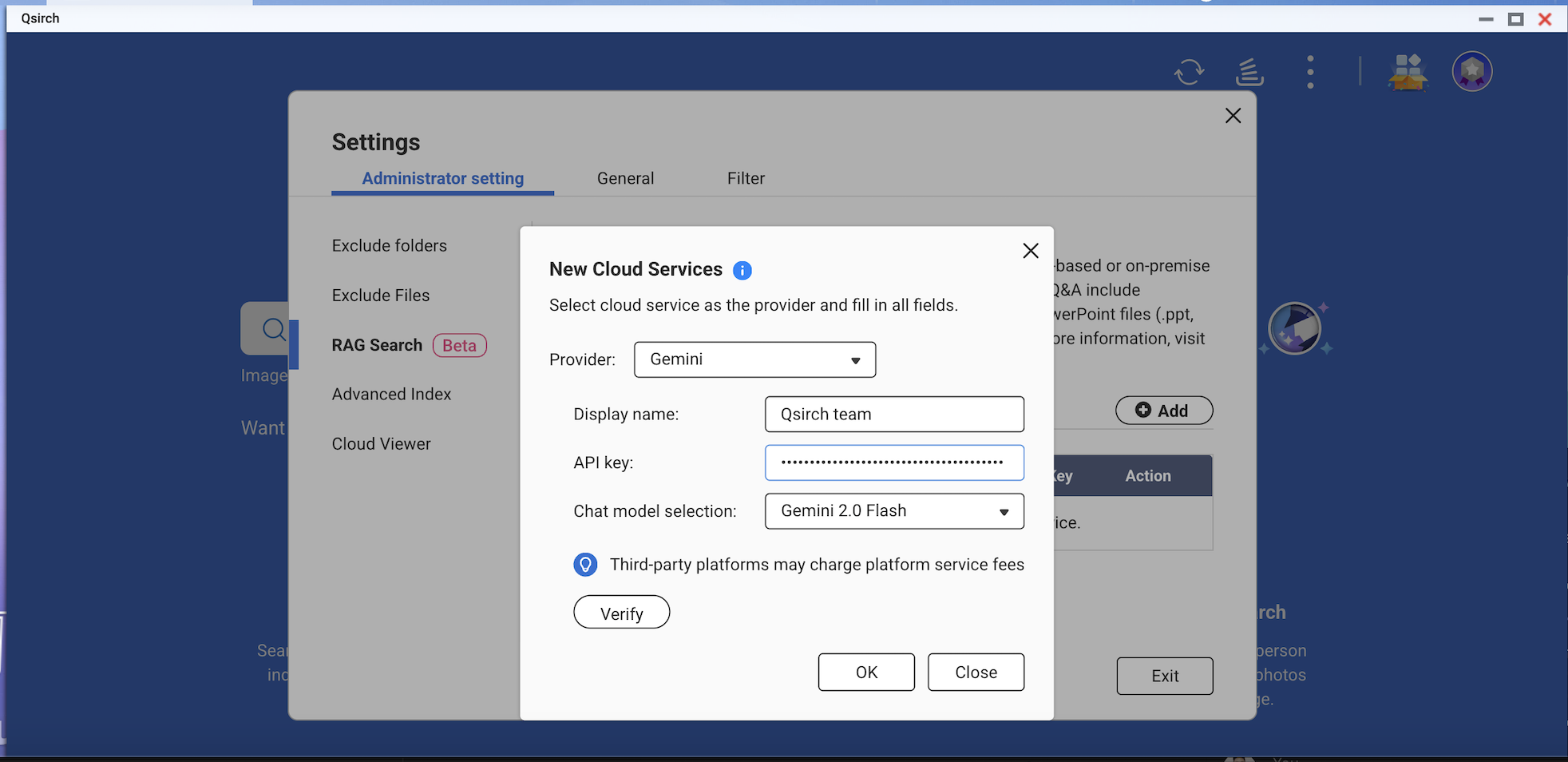

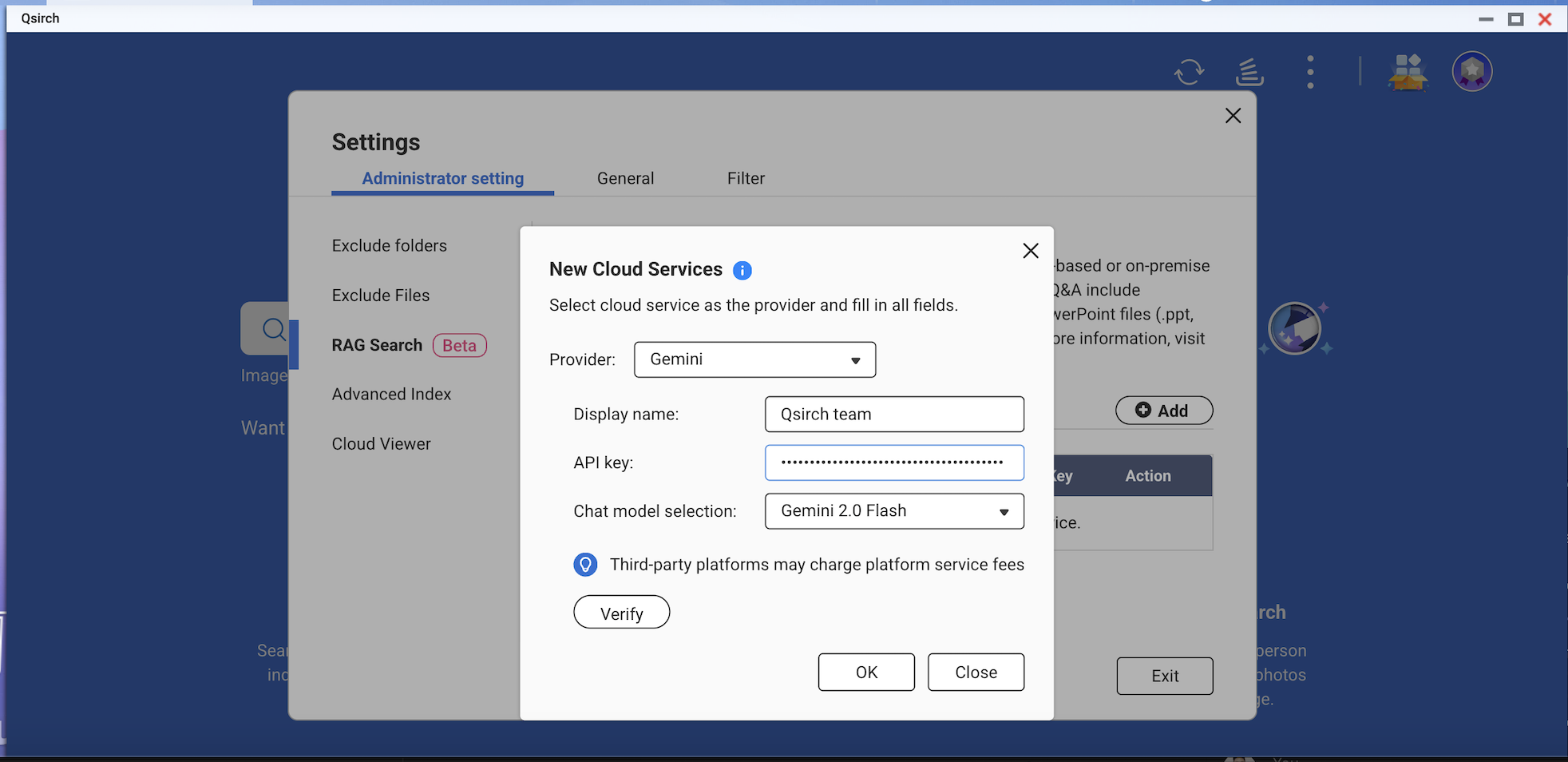

Gemini (Google Cloud AI)

Gemini (Google Cloud AI) provides a set of models designed for high-performance reasoning and RAG. Follow the steps below to apply for an API key:

- Visit the Google Gemini API Documentation.

- Get a Gemini API key in Google AI Studio.

- Sign in to your Google account.

- Click Create API key.

For more information, see Google Cloud AI Documentation.

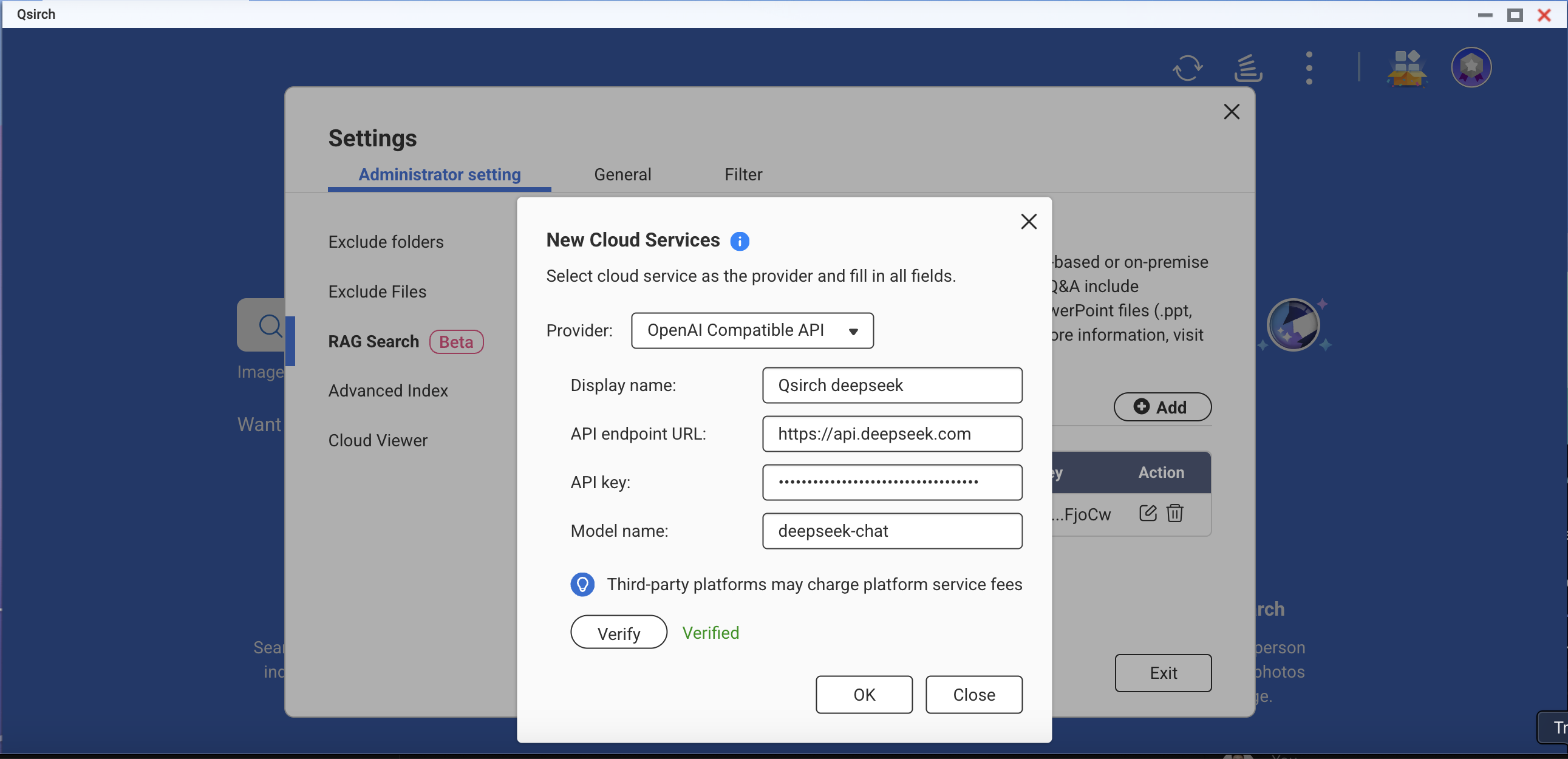

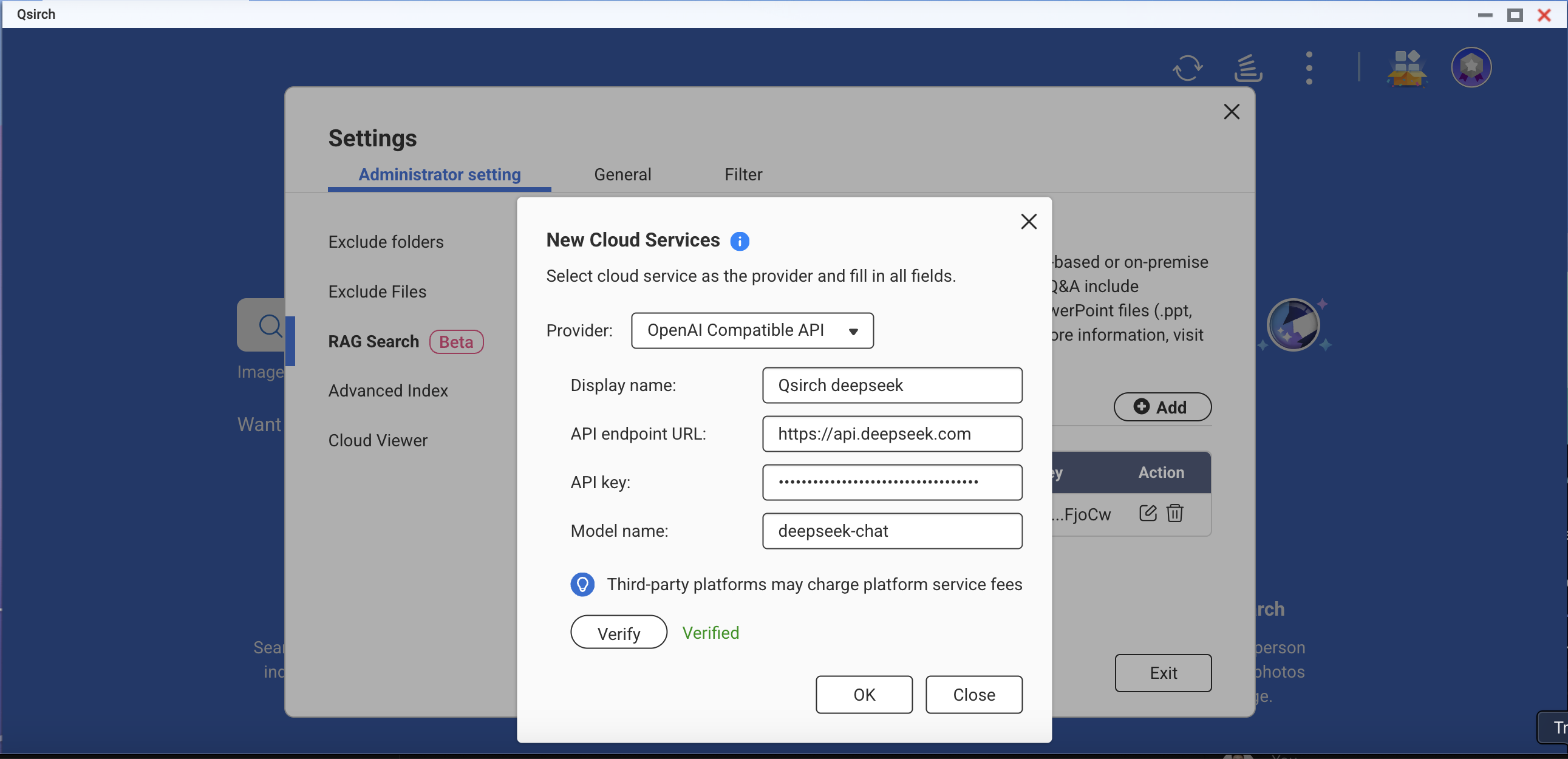

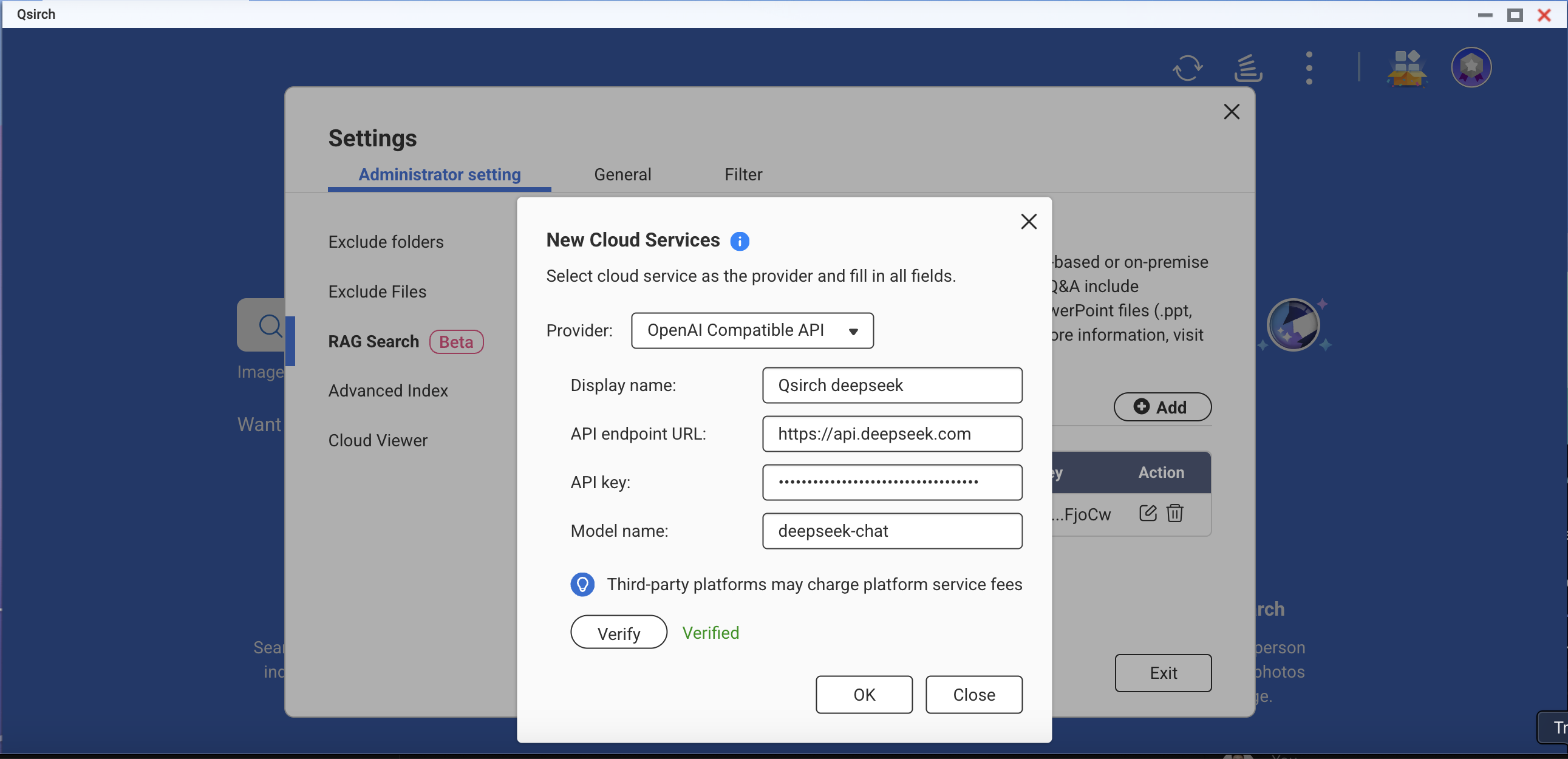

OpenAI-Compatible API

OpenAI Compatible API allows users to access various AI models beyond OpenAI’s own offerings, including models like DeepSeek and Grok, using the same API format. This enables seamless integration with existing applications built for OpenAI API. Follow the steps below to apply for an API key:

- Choose a provider that supports OpenAI-compatible API (for example, DeepSeek or Grok).

- Sign up on the provider's platform.

- Generate an API key in the account settings.

- Update your API endpoint and model settings as required.

For more information, refer to the provider's official API documentation.

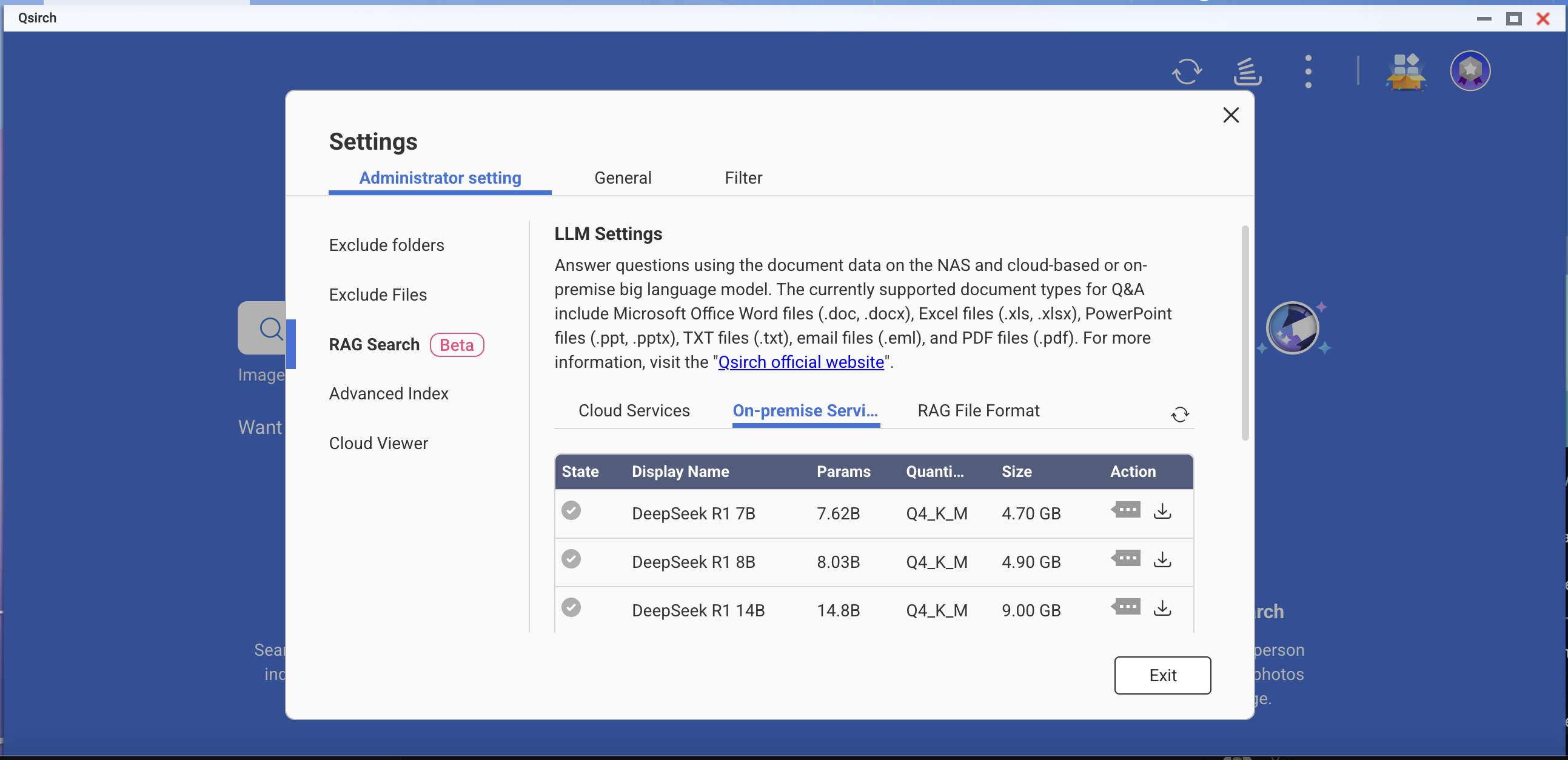

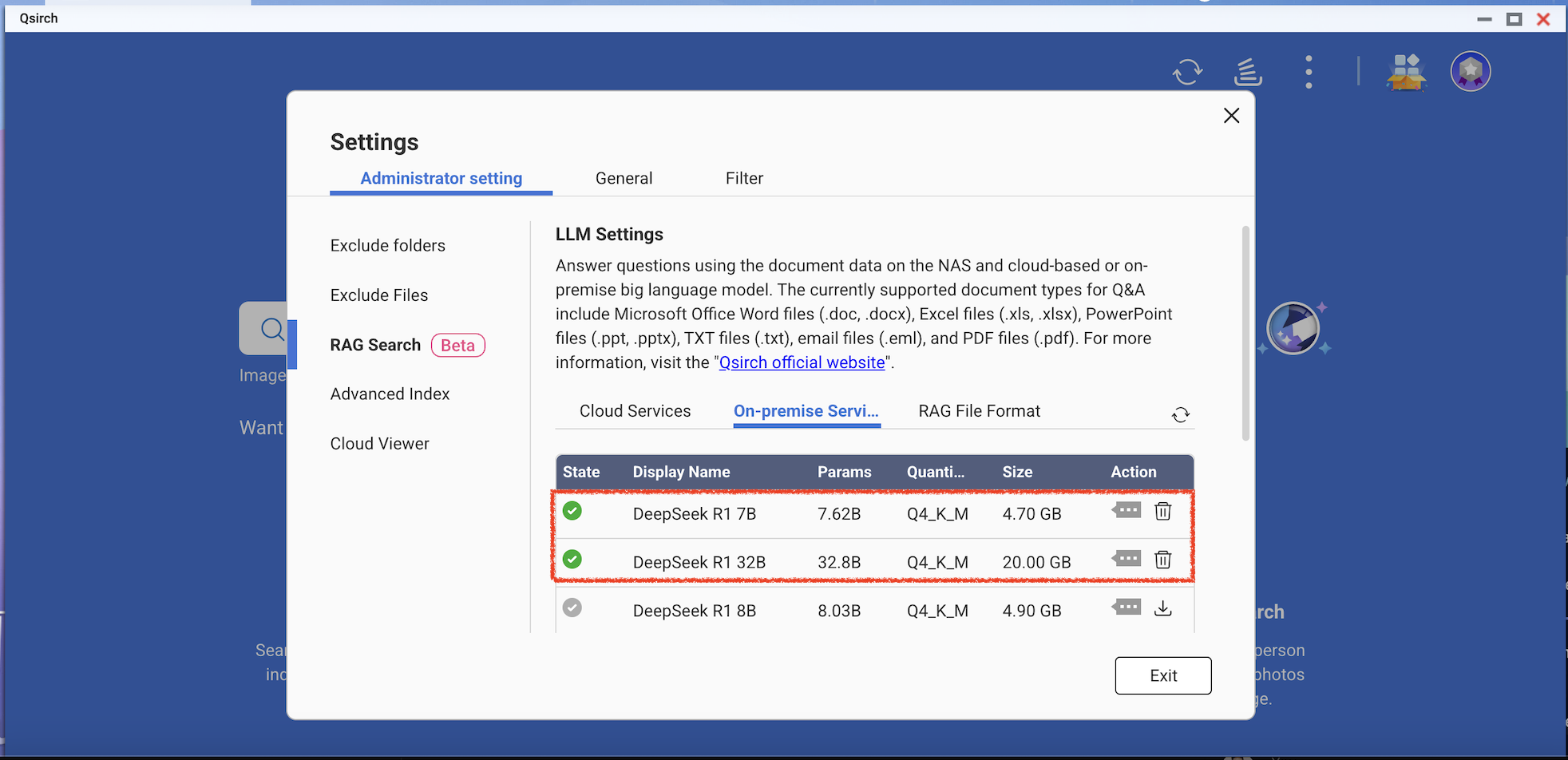

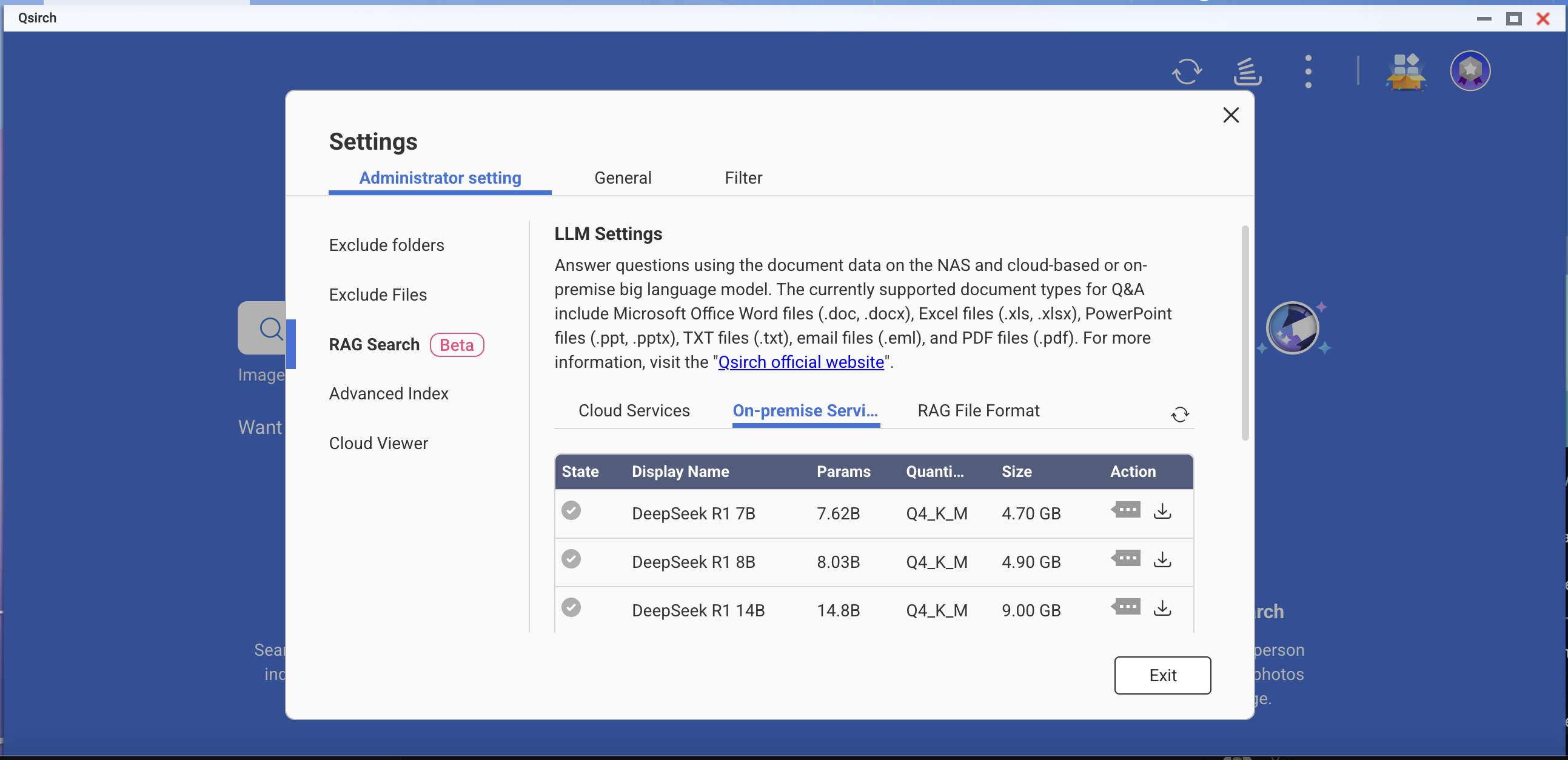

On-Premise RAG Search

For advanced users and enterprises who require full data privacy or offline AI capabilities, Qsirch offers on-premise RAG search powered by locally hosted LLMs. This mode runs entirely on your NAS or connected hardware, without sending data to external services.

To enable on-premise RAG:

- Ensure that the LLM Core is ready.

- Set the GPU to Container Station mode (Go to Control Panel > Hardware > Hardware Resources > Resource Use > Container Station mode).

How to Use RAG Search in Qsirch

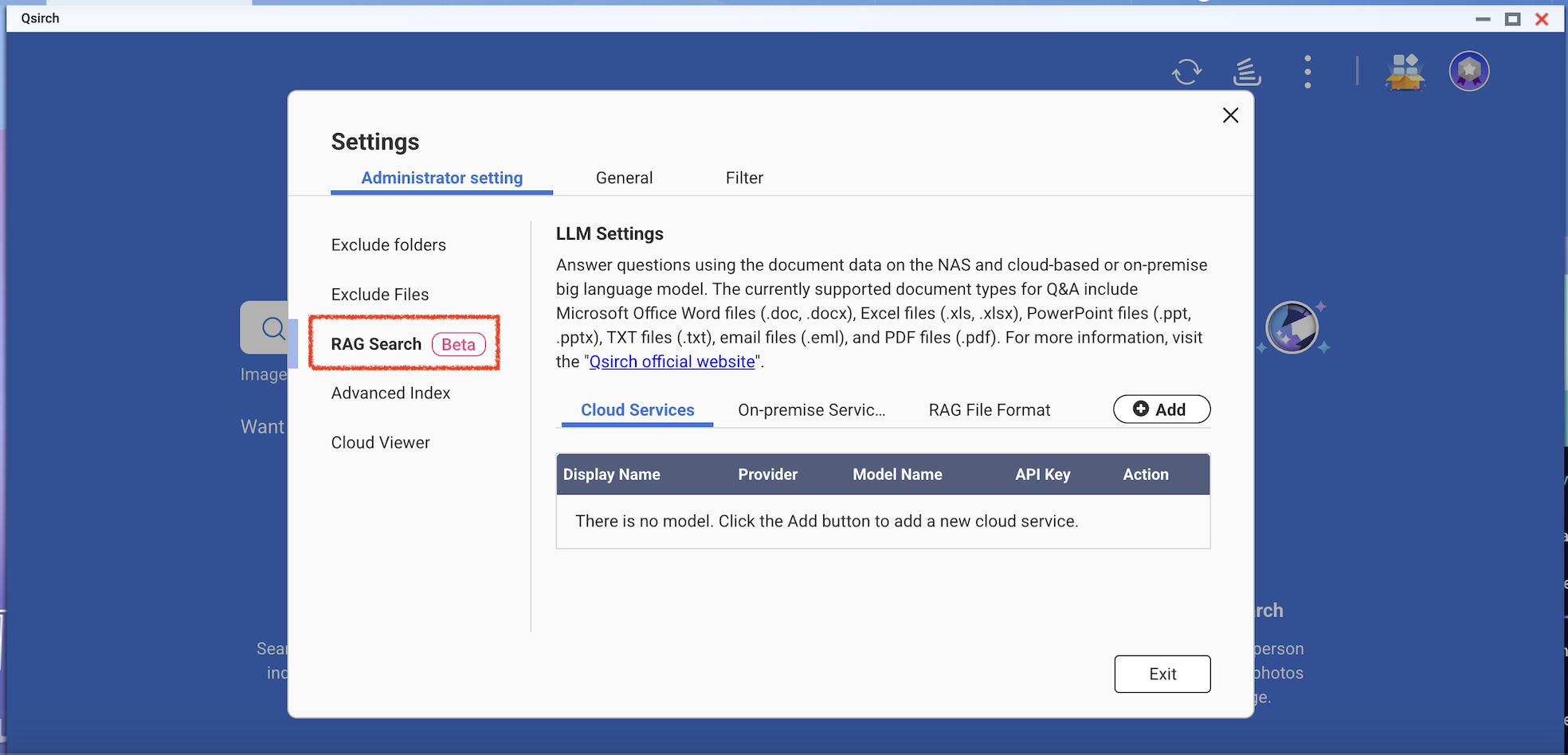

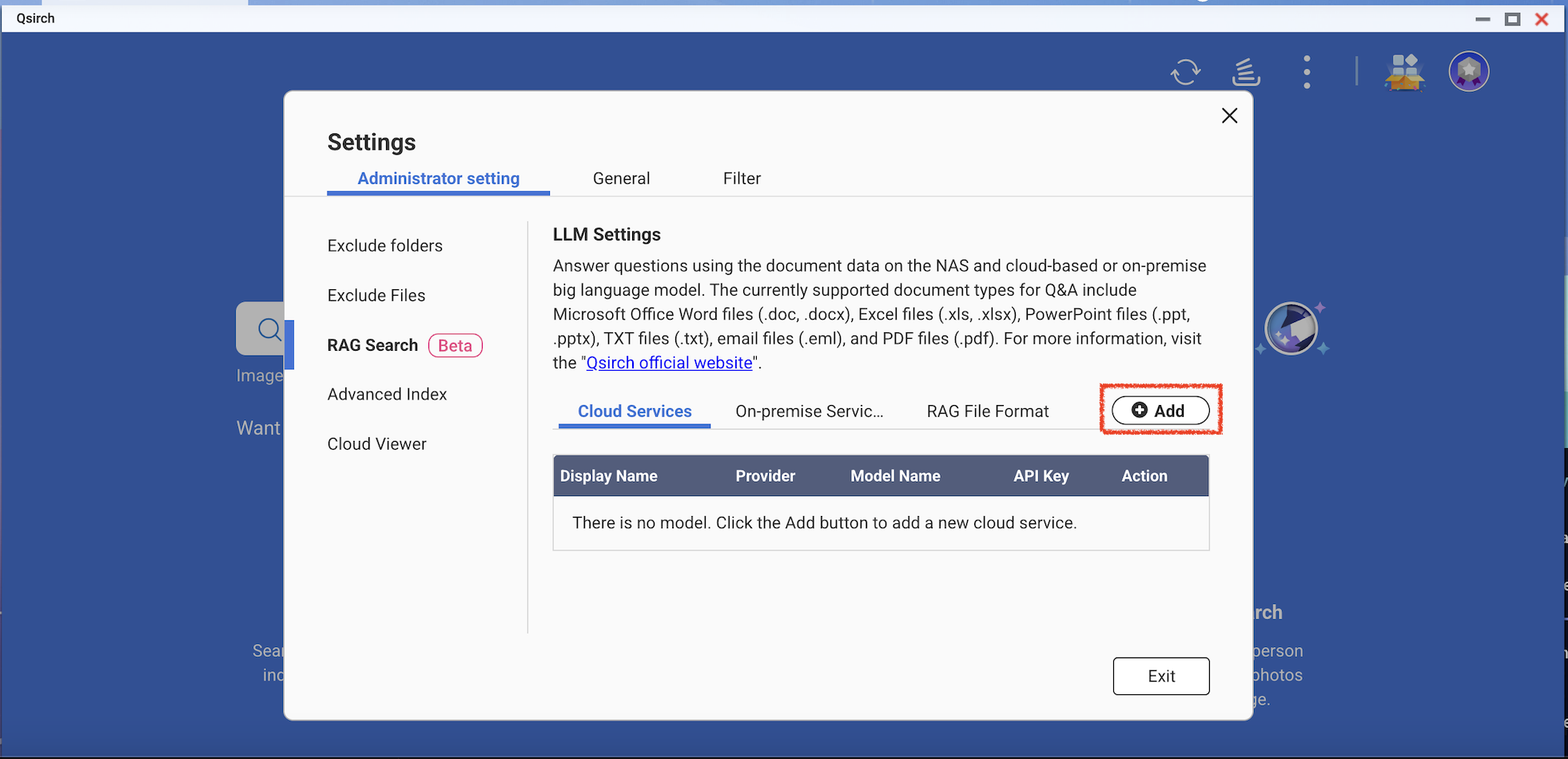

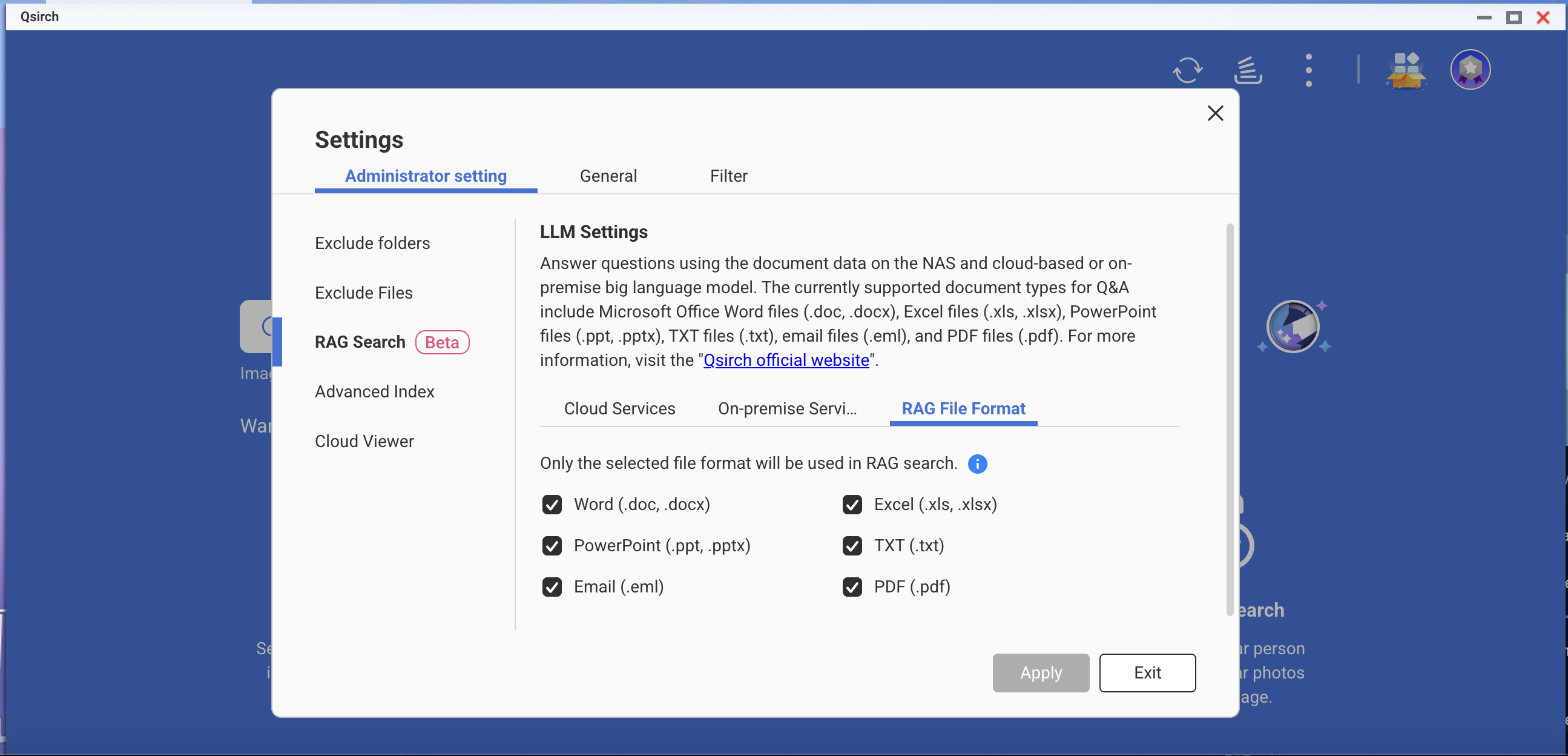

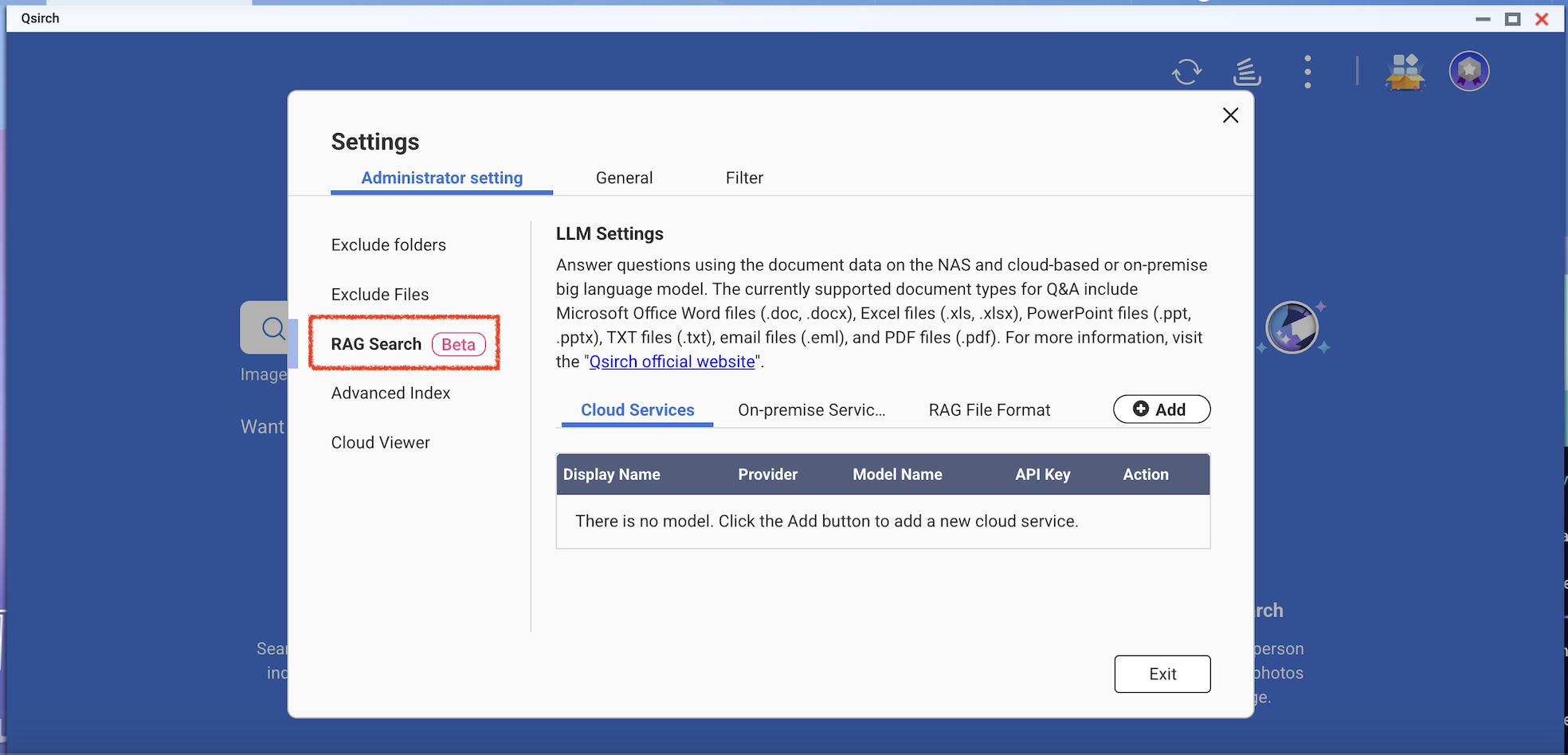

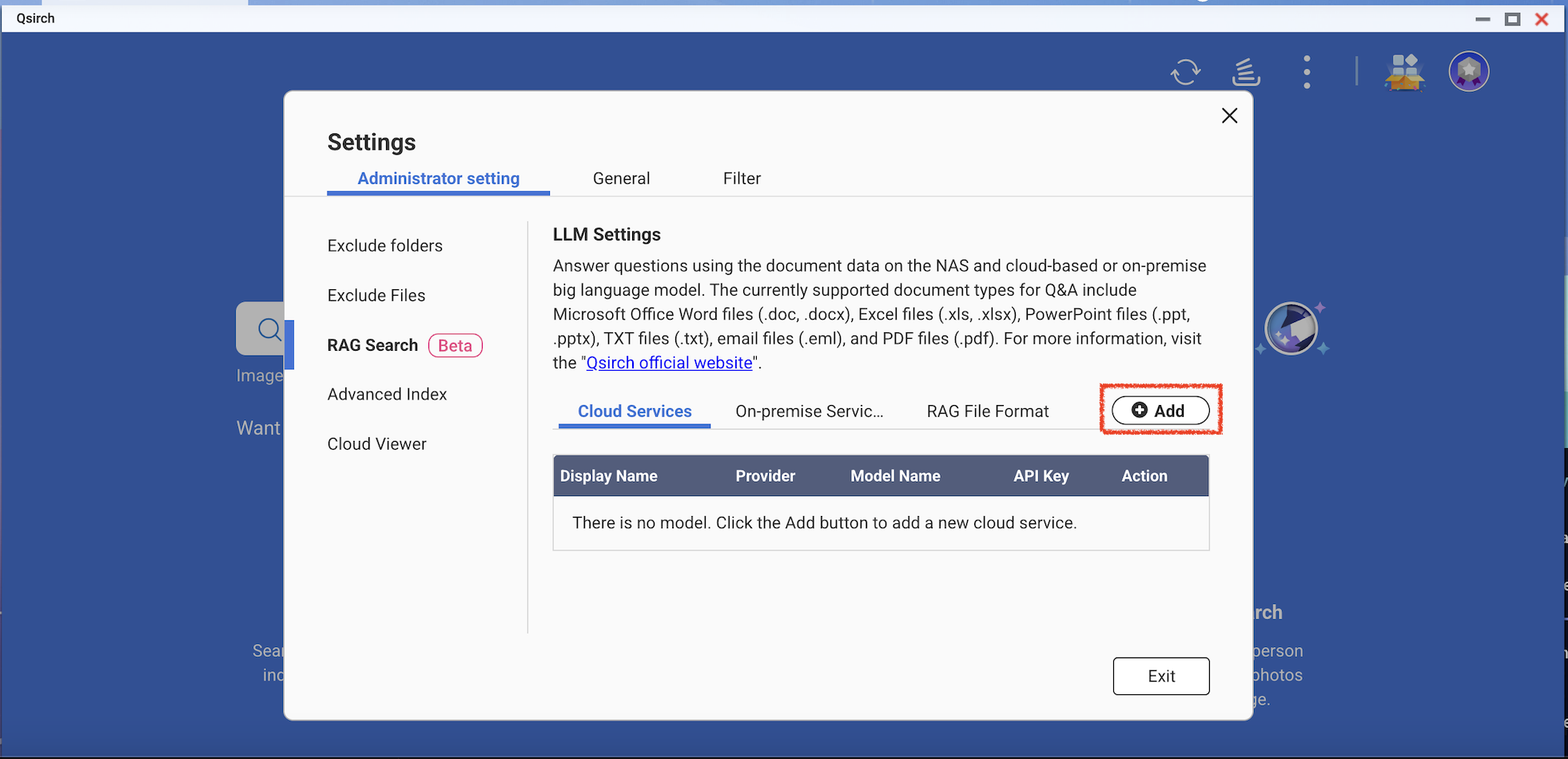

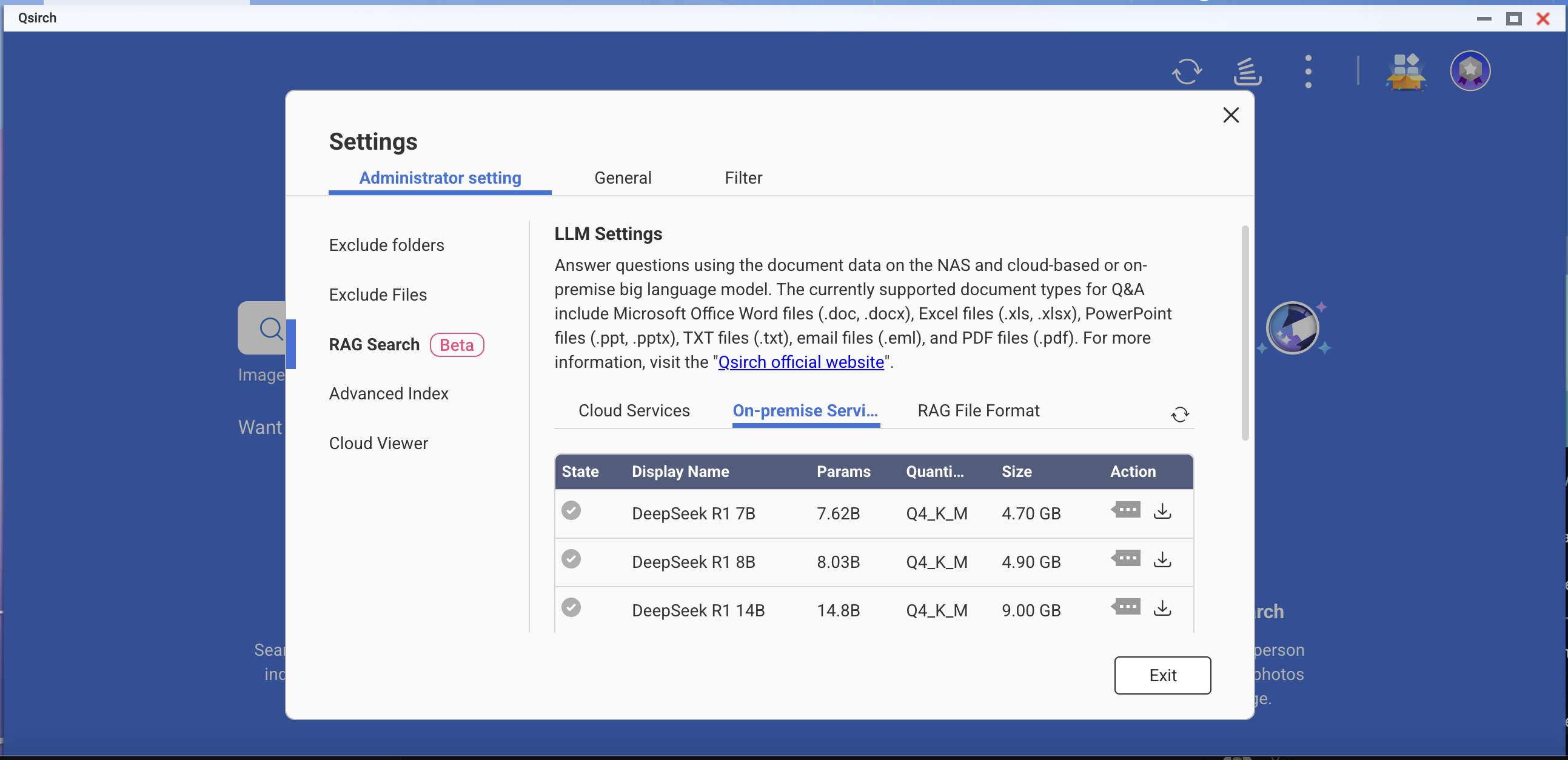

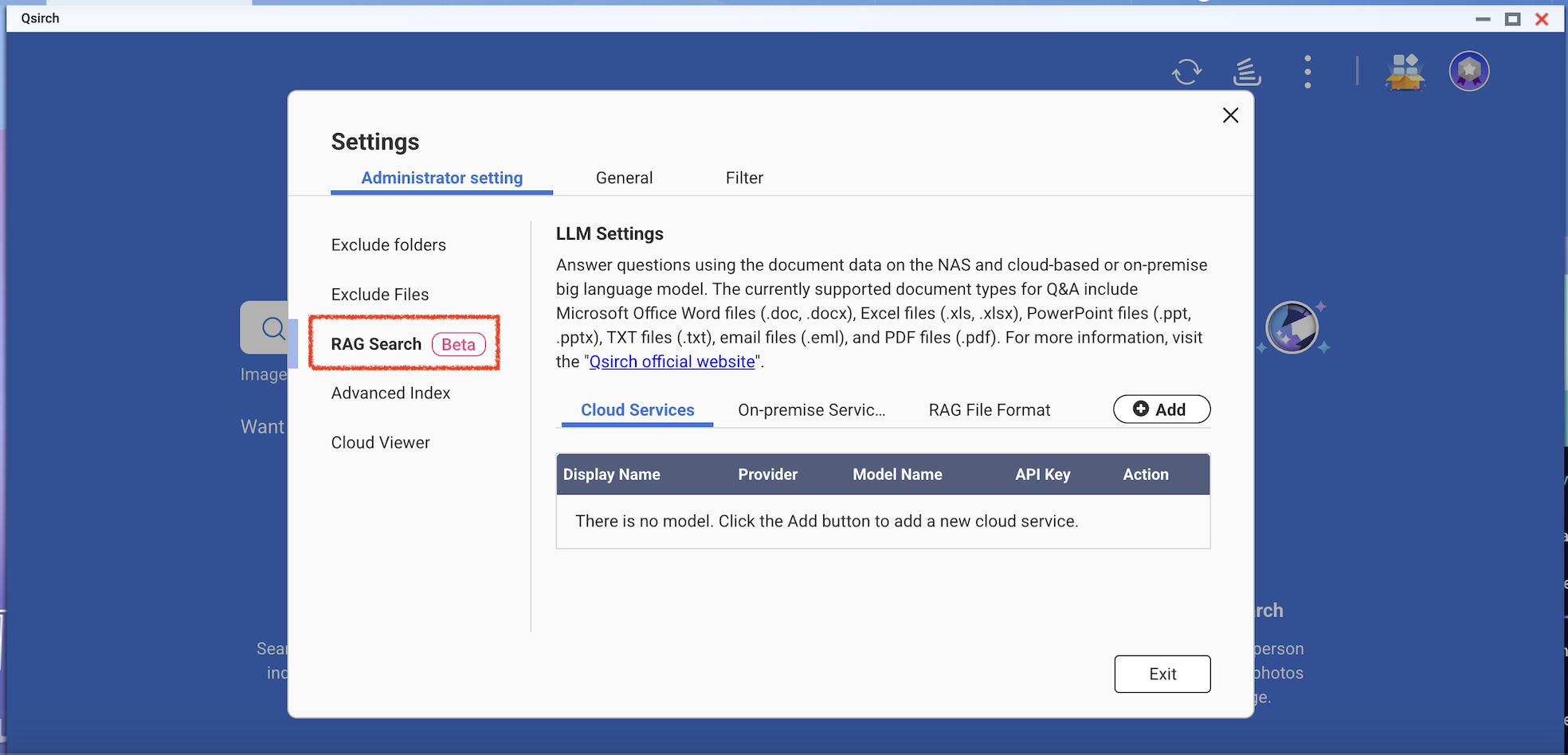

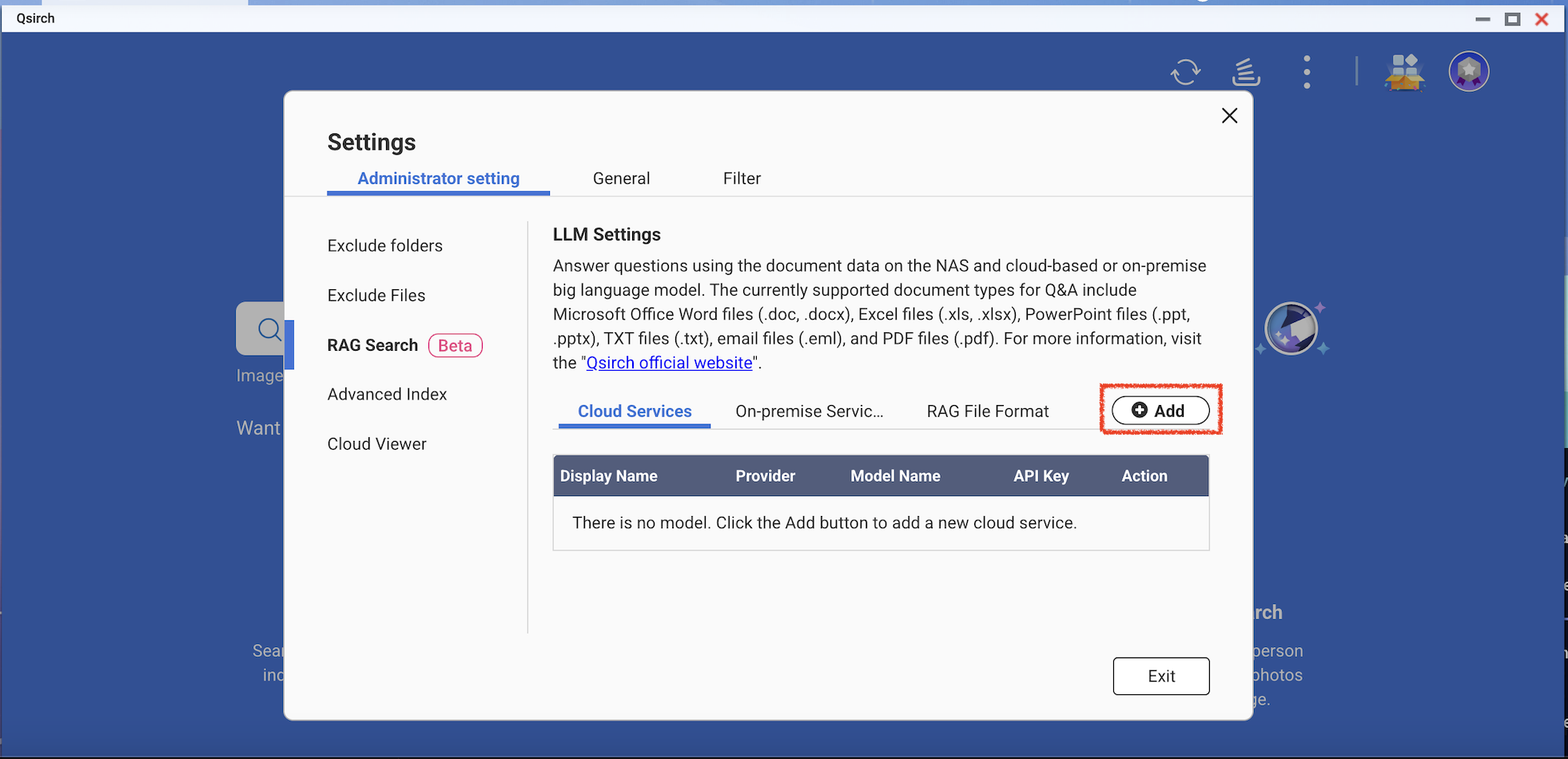

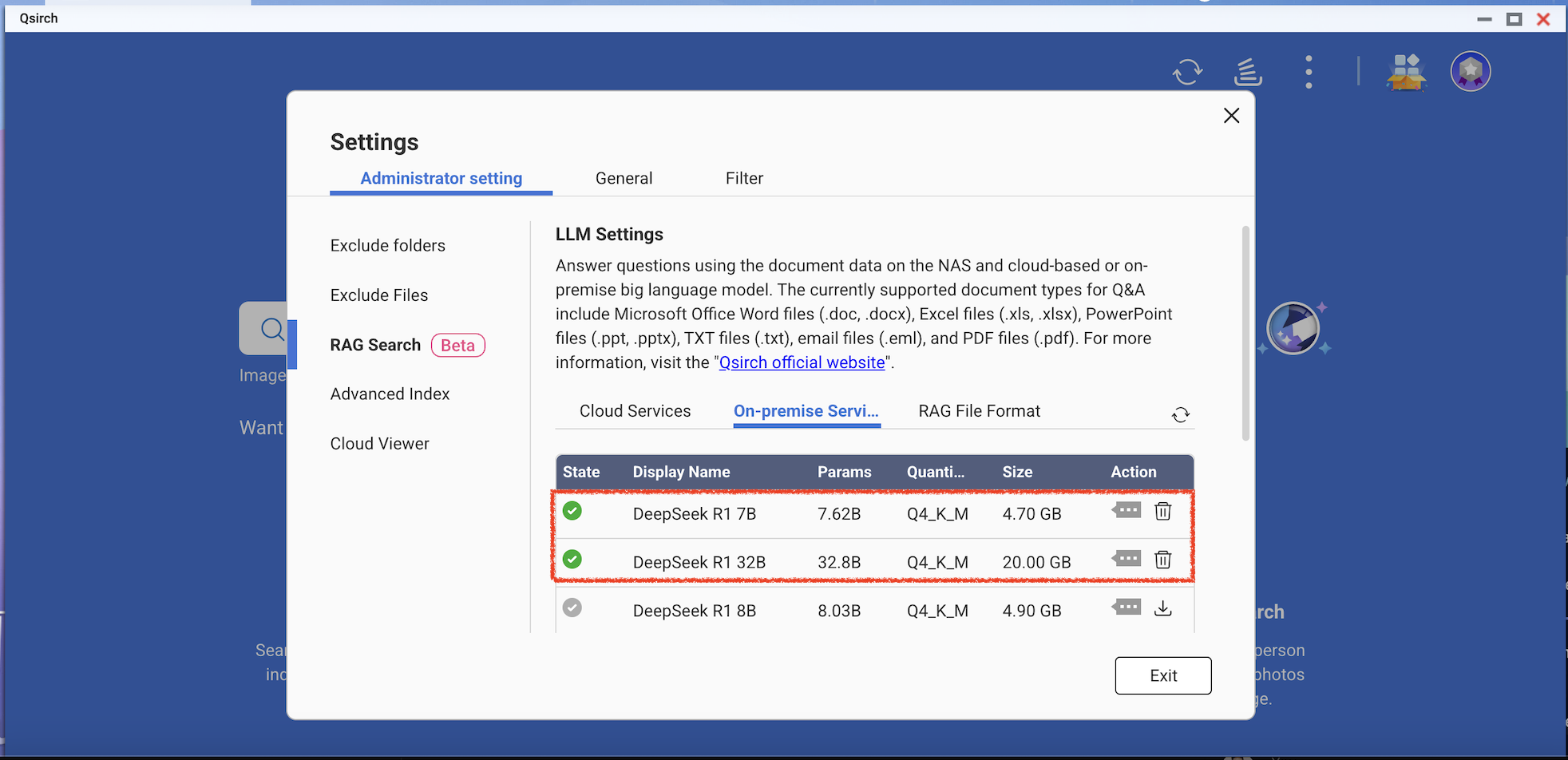

- Go to Settings > Administrative setting > RAG Search.

- Add one or more cloud services to use RAG search.

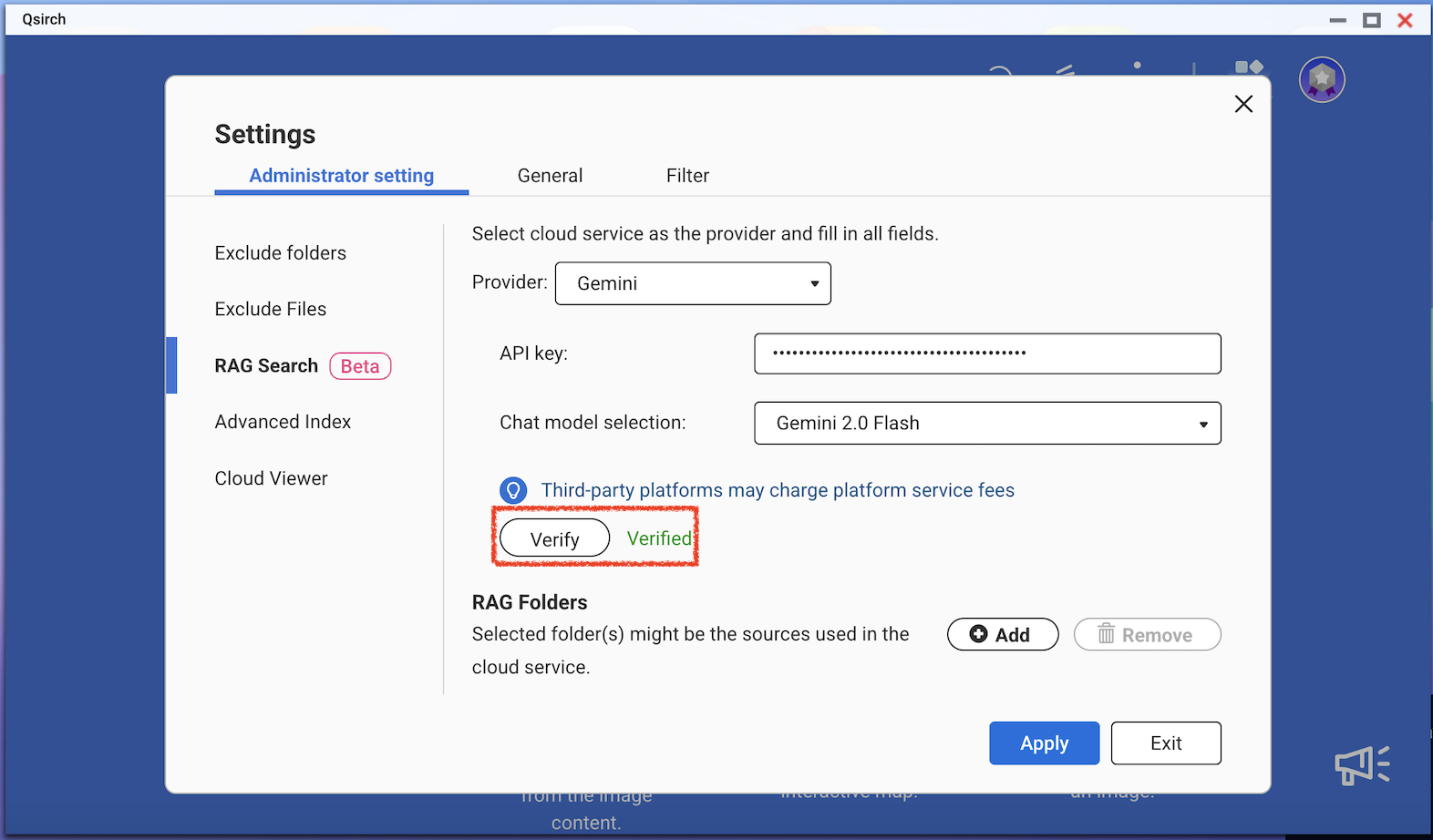

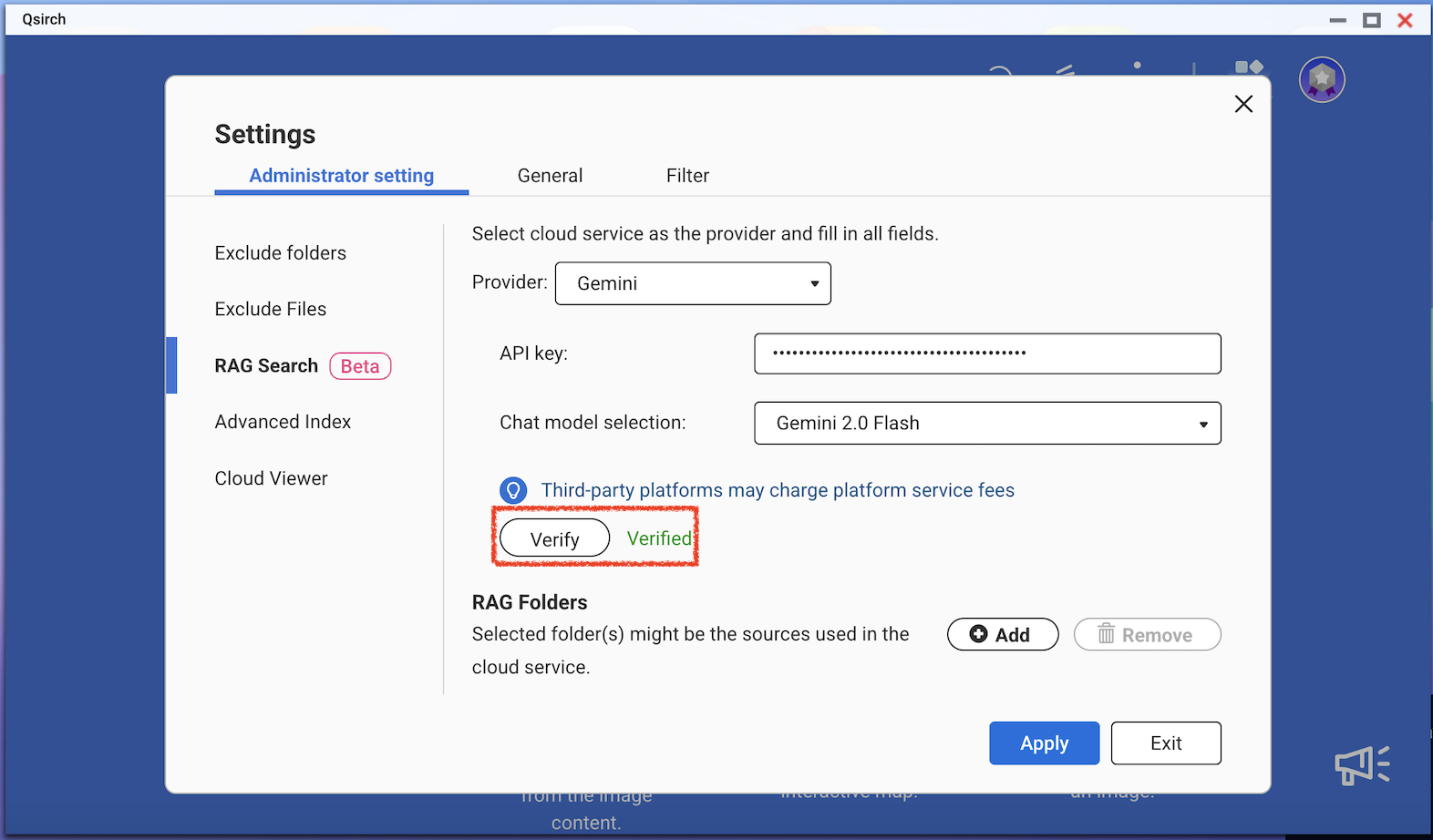

(Optional) Verify your API key. This helps check whether an API key is valid.

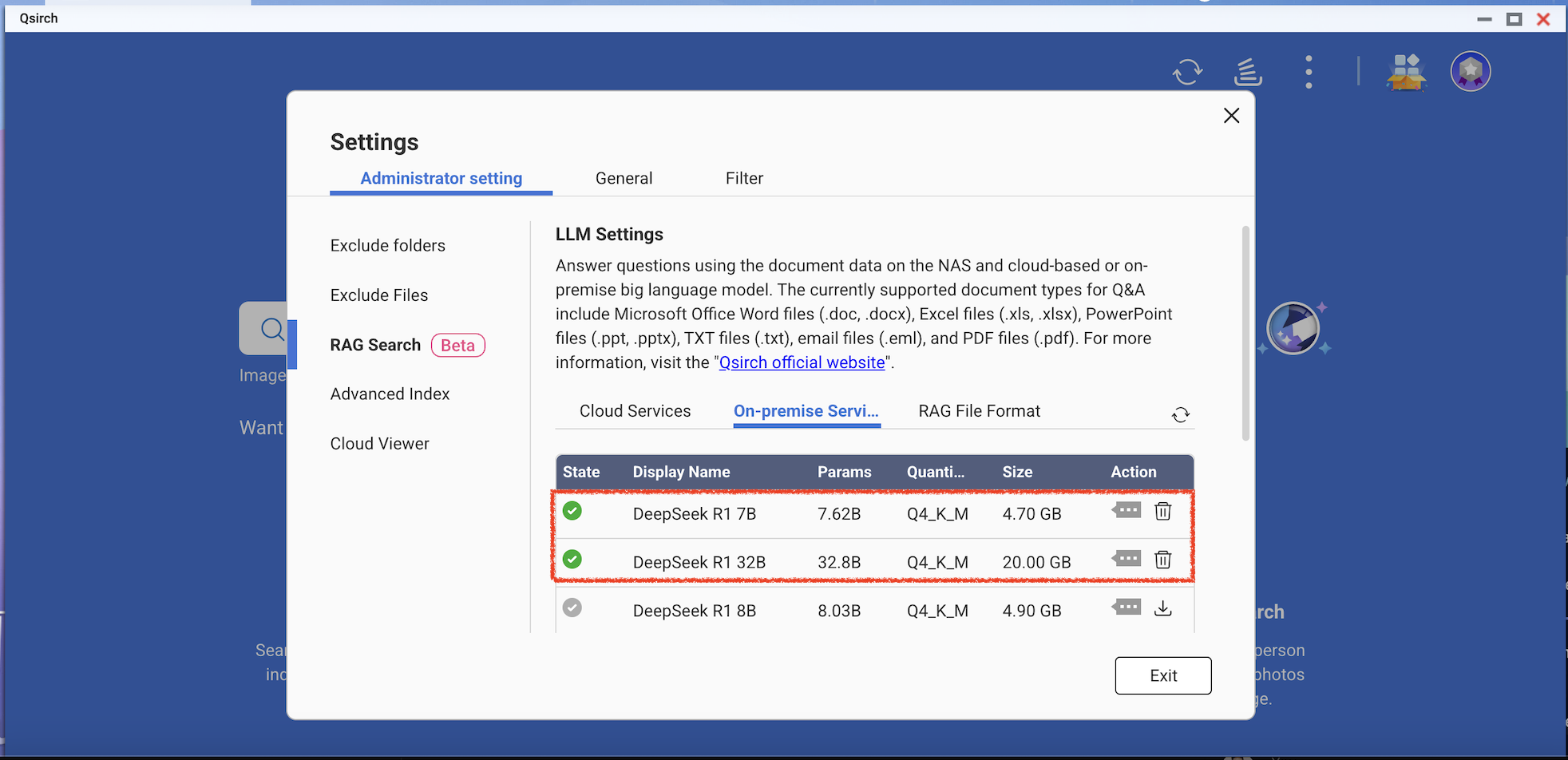

Download one or more edge models from the on-premise services. This feature can only be used on the specific NAS models.

- Add more AI models that are compatible with OpenAI API, including the GPT series, DeepSeek models, and Grok models.

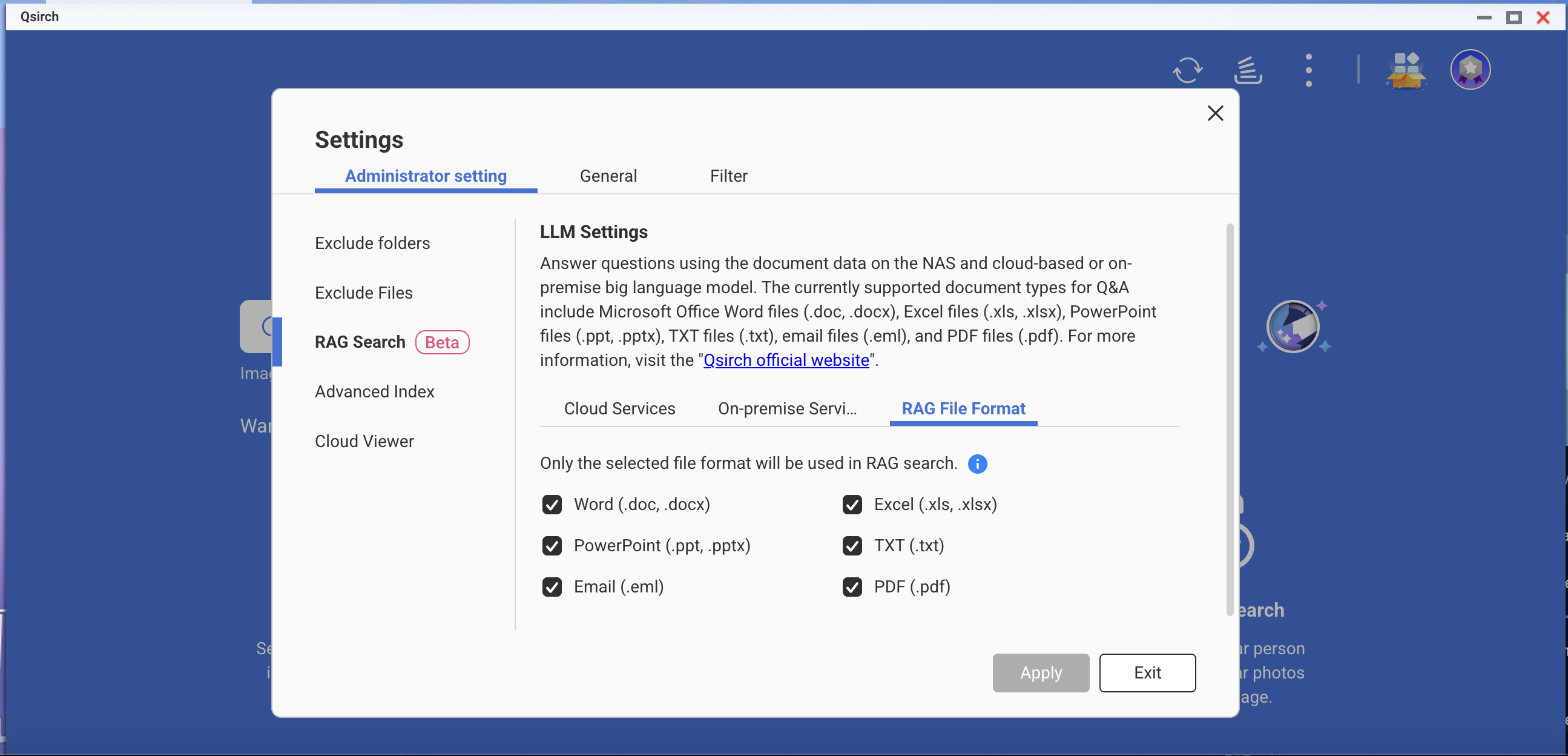

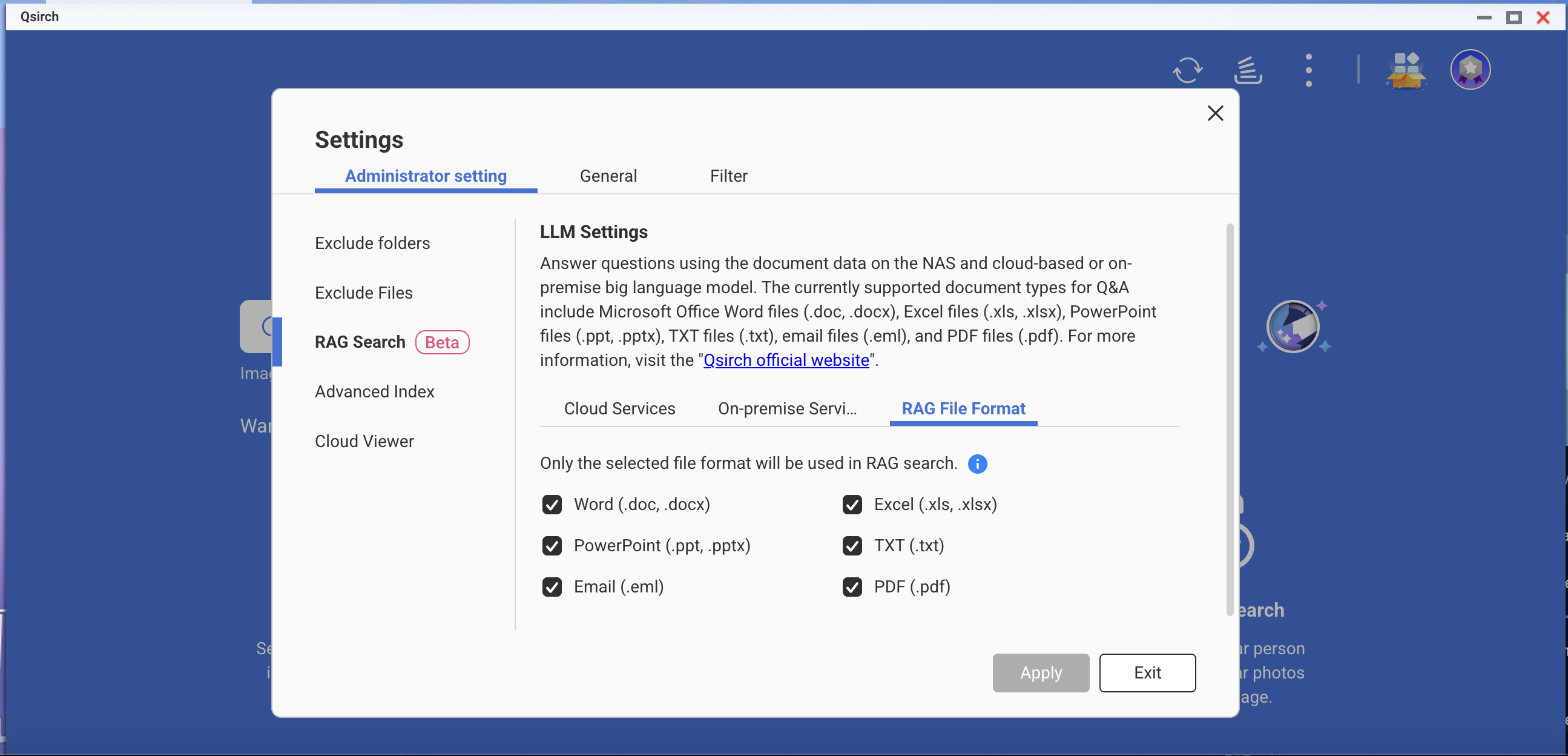

- Choose file formats for your RAG search.

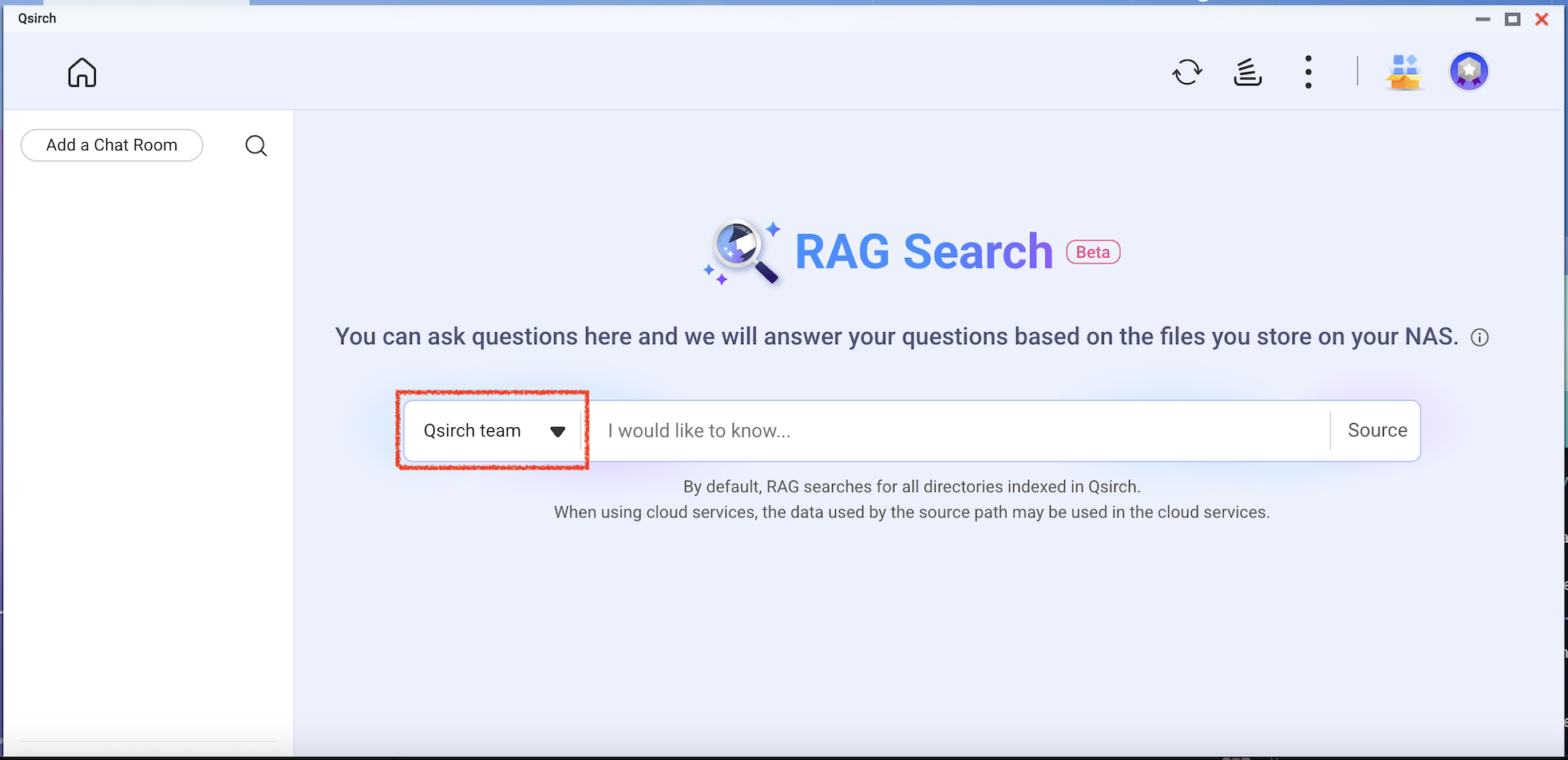

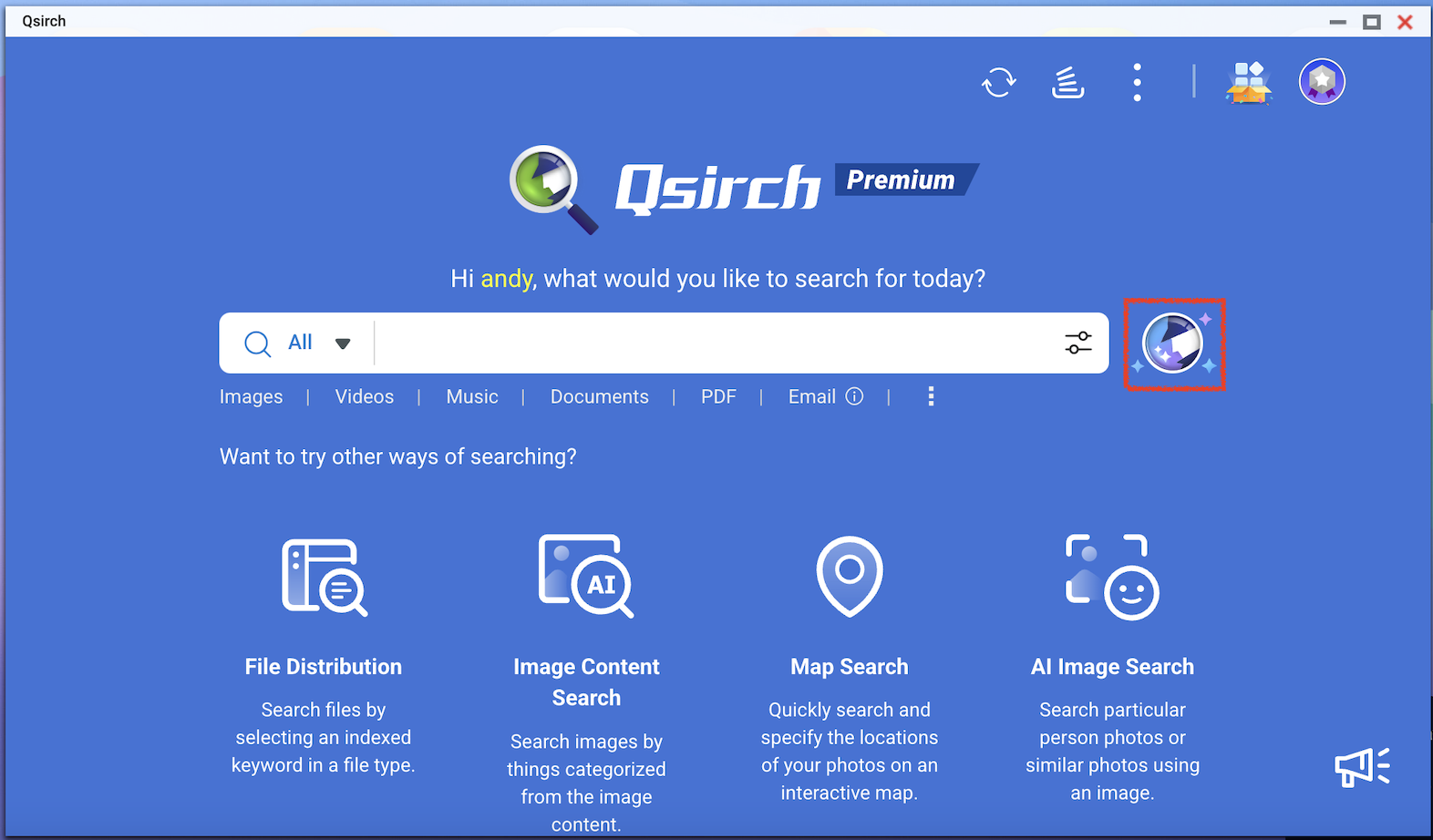

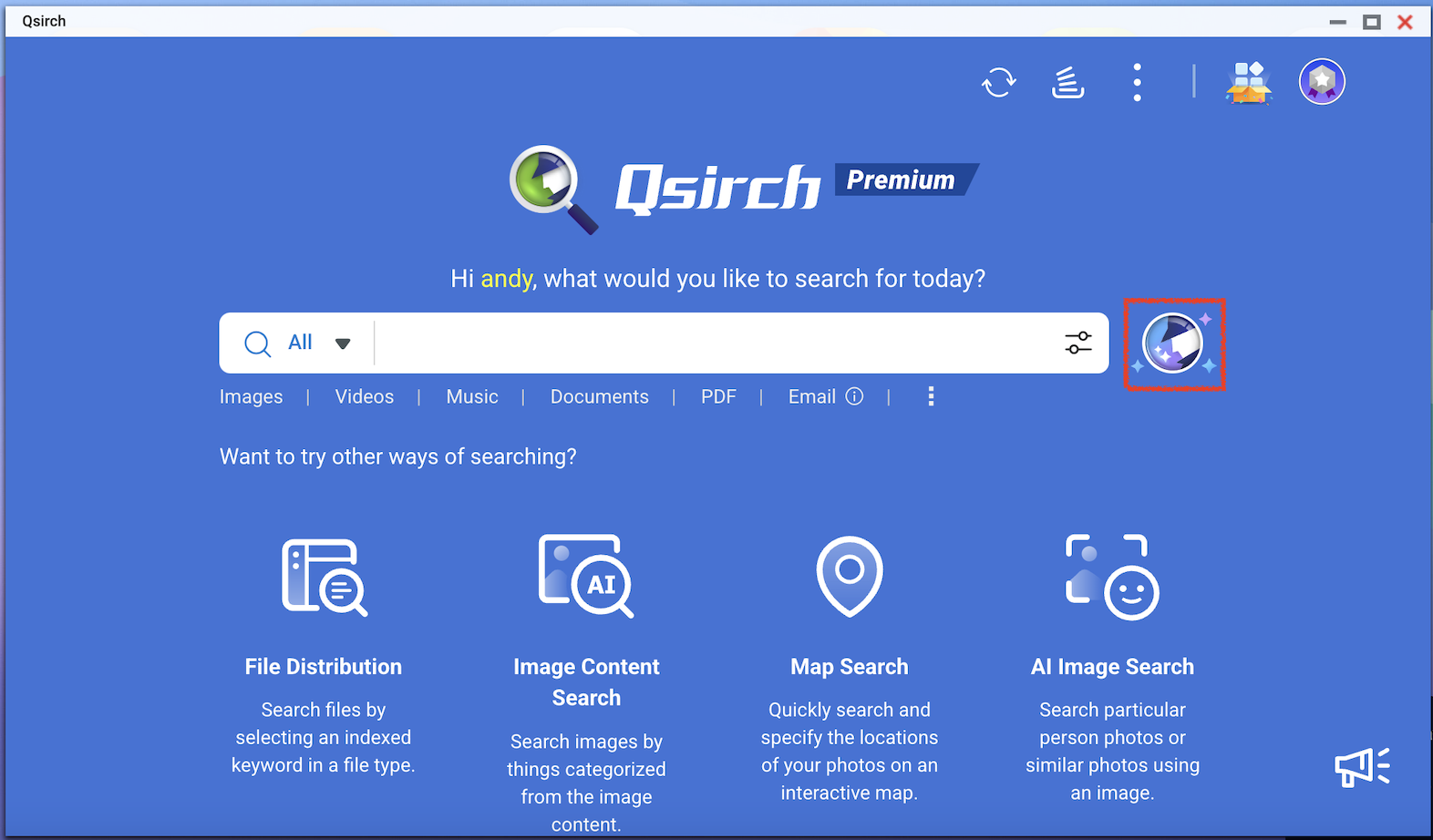

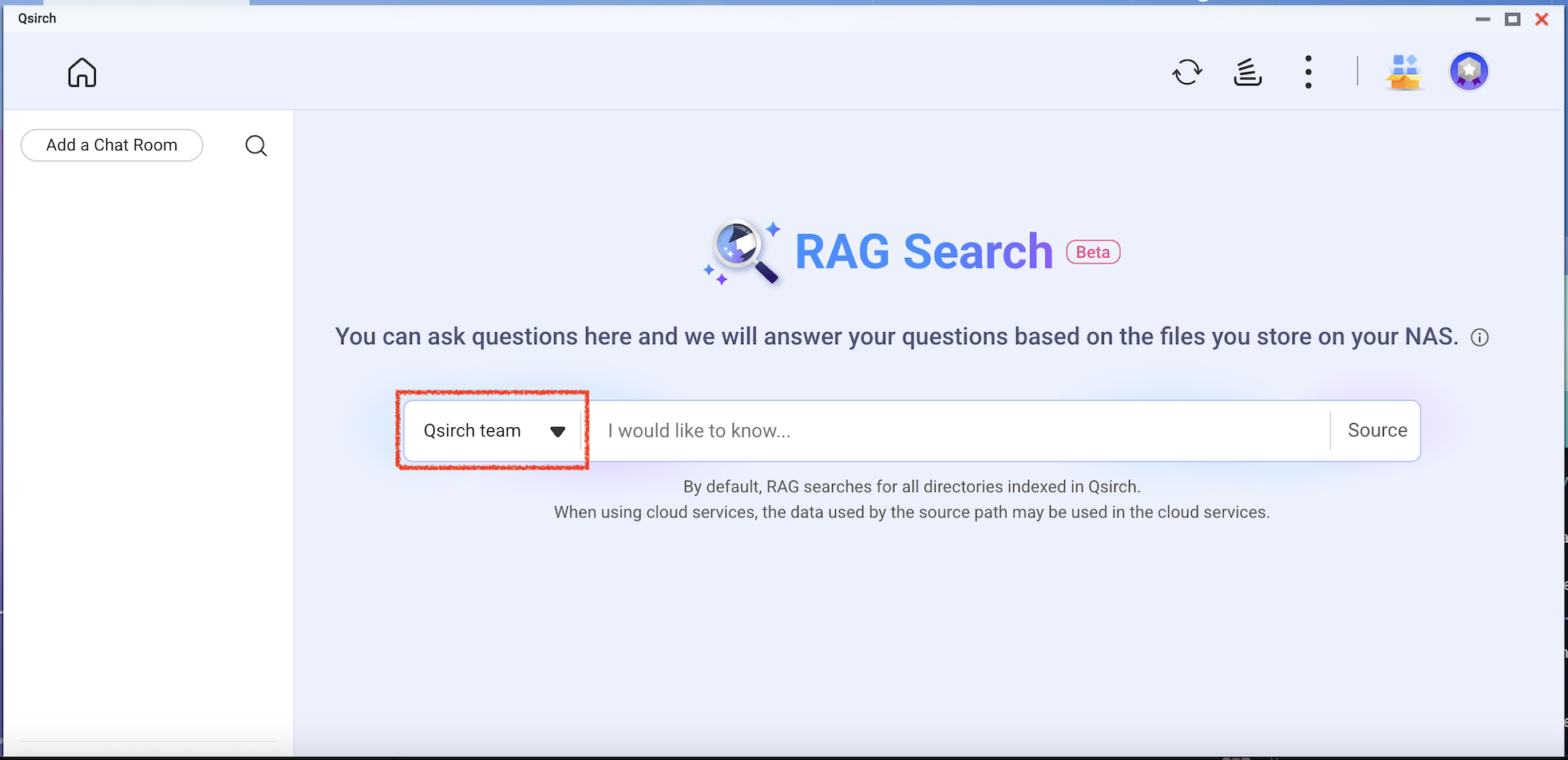

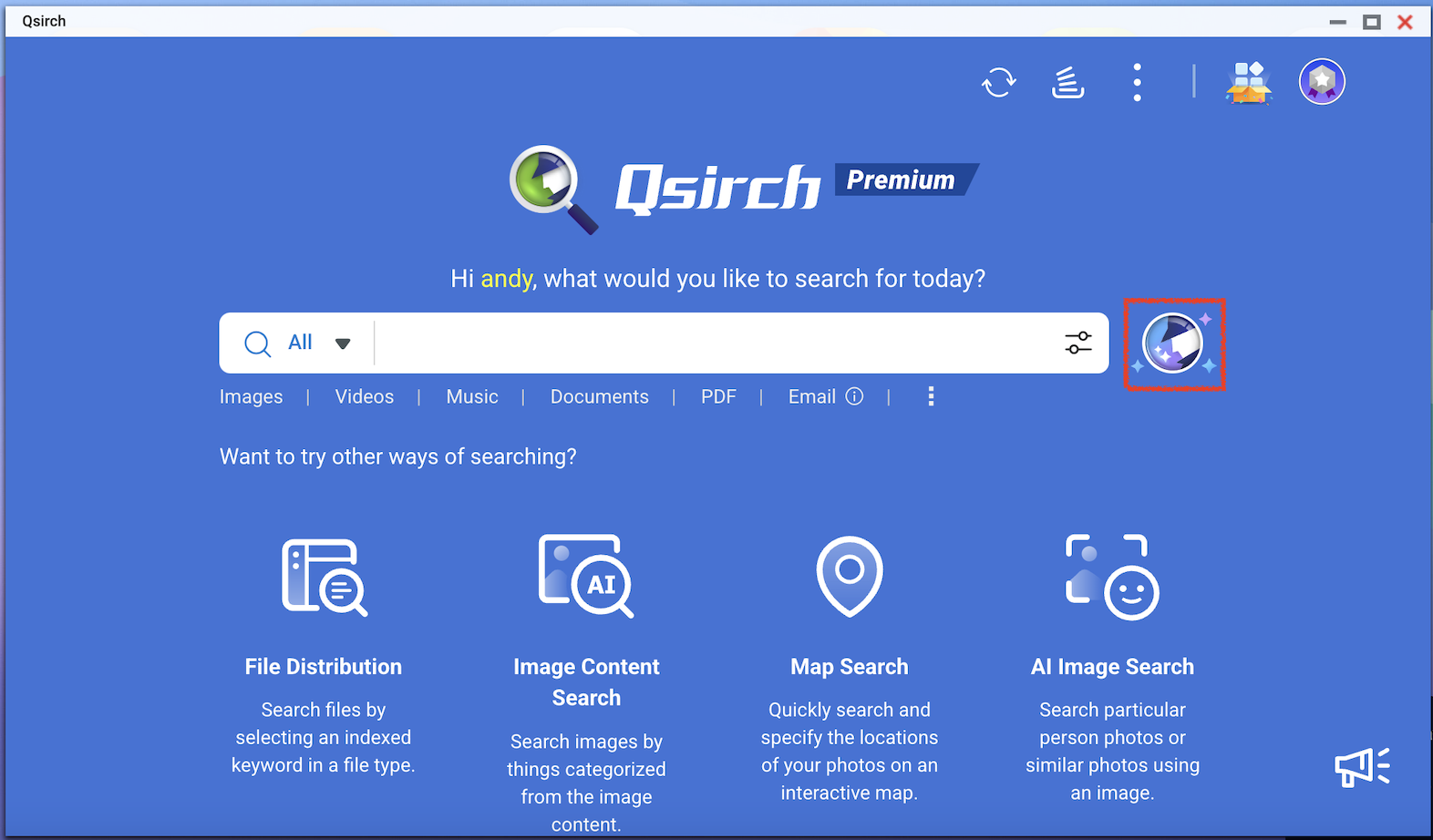

- Go to Qsirch home page and click the RAG search button.

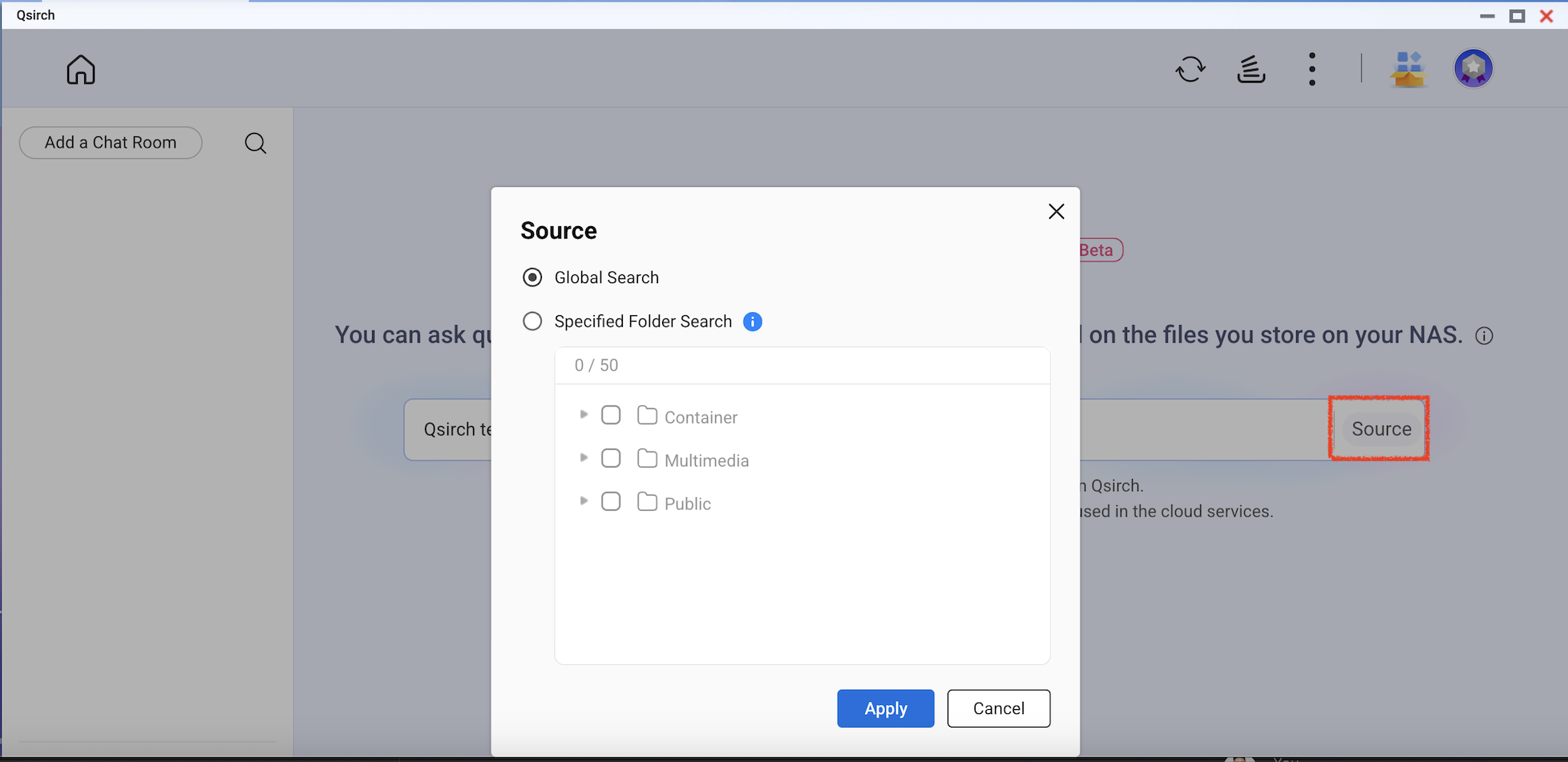

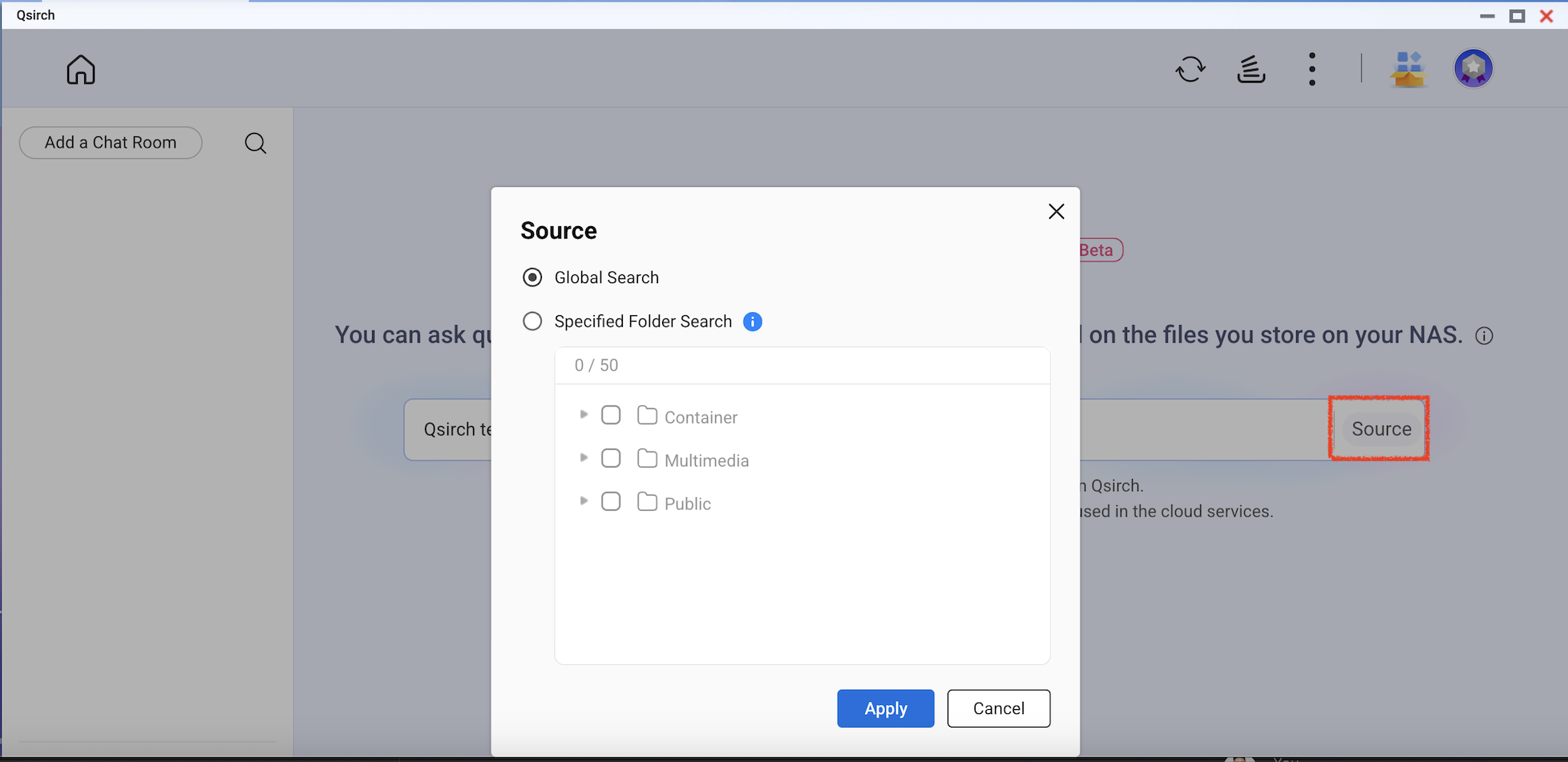

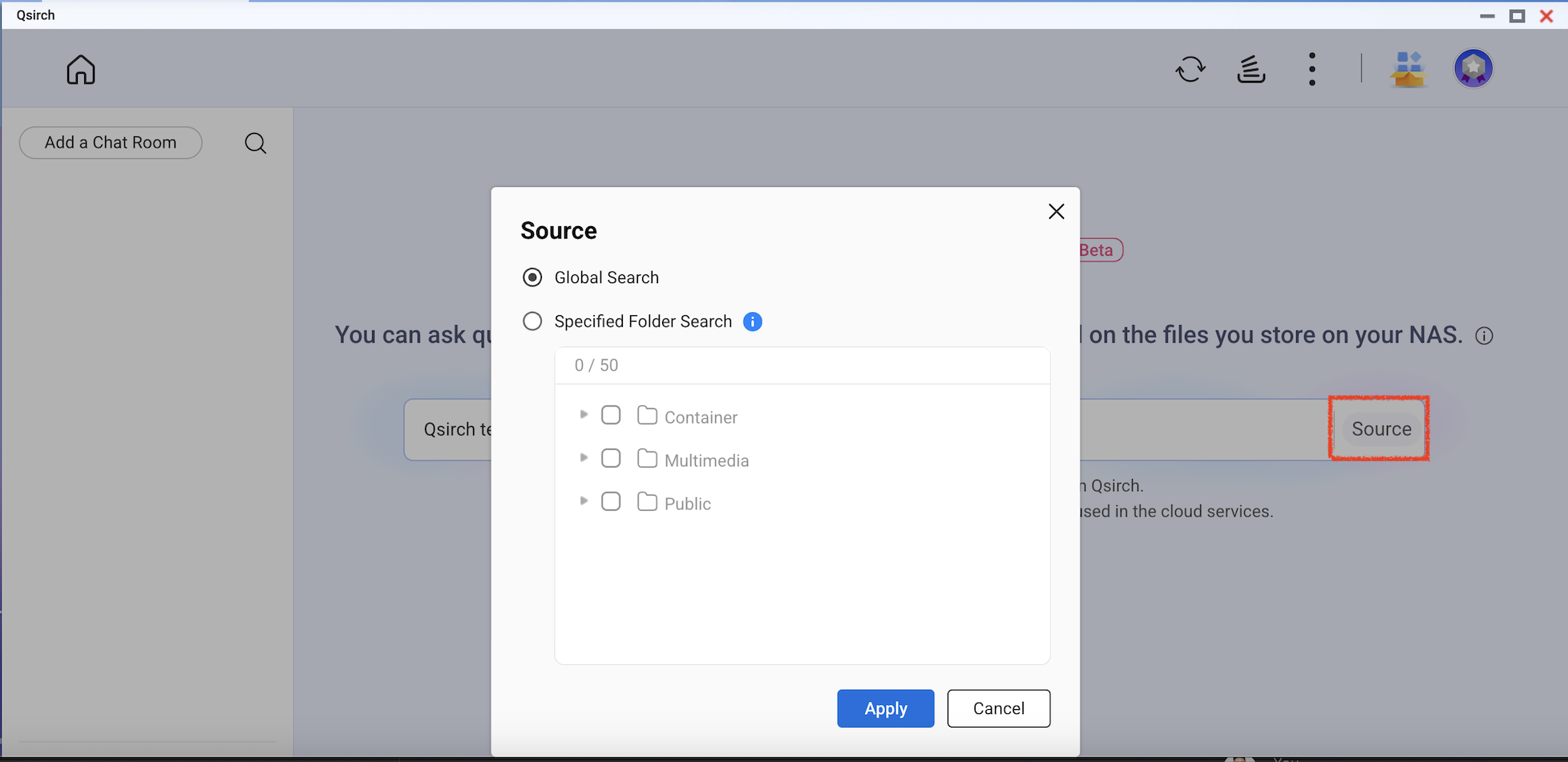

Qsirch RAG search will only use the files included in "Source" for data retrieval.

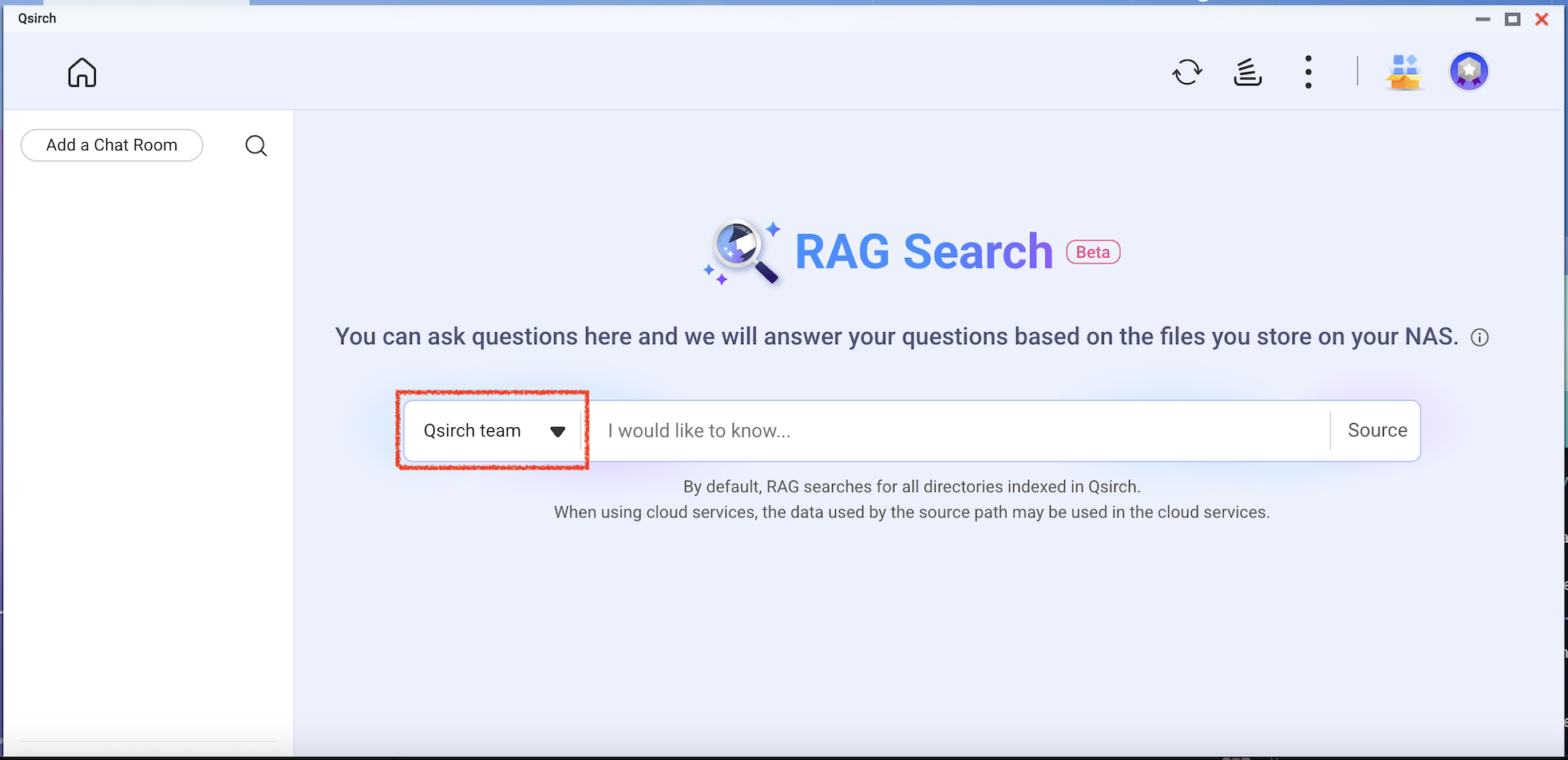

Check the model you want to use and then start using RAG search.

适用产品

Qsirch 6.0.0(或更高版本)在所有平台上

Qsirch RAG 搜索与云端和本地 LLMs

Qsirch 支持使用基于云的大型语言模型(LLMs)的检索增强生成(RAG),以提供更贴合且具上下文意识的响应。当您输入查询时,Qsirch 从您的 NAS 中检索相关文档,并将其用作语言模型的上下文。这种搜索与生成式 AI 的结合使 Qsirch 能够根据您自己的数据生成更精细且信息丰富的答案。

Qsirch 还支持多轮对话,实现自然且具上下文意识的互动。用户可以在不重复先前上下文的情况下提出后续问题,并且上下文在多轮对话中得以保留,以提供连贯的答案。多轮对话支持适用于云端和本地 RAG 模式。

将 RAG 与基于云的 AI 服务集成

要集成 RAG 搜索,您必须首先从您选择的 AI 服务获取 API 密钥。

ChatGPT(OpenAI API)

ChatGPT(OpenAI API)为 RAG 嵌入和生成响应提供强大的 GPT 模型。请按照以下步骤申请 API 密钥:

- 在 OpenAI 上注册一个账户:https://auth.openai.com/create-account

- 在账户设置中创建一个 API 密钥。

欲了解更多信息,请参见OpenAI API 文档。

Azure OpenAI

Azure OpenAI 通过 Azure 基础设施提供对 OpenAI 模型(如 GPT-4.1)的访问,较为适合企业解决方案。请按照以下步骤申请 API 密钥:

- 登录到Azure 门户。

- 选择您的 OpenAI 资源(如果您还没有,请创建一个)。

- 在左侧菜单中,点击密钥和终端。

- 复制一个 API 密钥并复制 API 请求的终端(基本 URL)。

欲了解更多信息,请参见 Azure OpenAI 文档。

Gemini(Google Cloud AI)

Gemini(Google Cloud AI)提供了一组为高性能推理和 RAG 设计的模型。请按照以下步骤申请 API 密钥:

- 访问Google Gemini API 文档。

- 在 Google AI Studio 获取 Gemini API 密钥。

- 登录您的 Google 账户。

- 点击创建 API 密钥。

欲了解更多信息,请参见 Google Cloud AI 文档。

OpenAI 兼容 API

OpenAI 兼容 API 允许用户访问除 OpenAI 自身产品之外的各种 AI 模型,包括 DeepSeek 和 Grok 等模型,使用相同的 API 格式。这使得与为 OpenAI API 构建的现有应用程序无缝集成。请按照以下步骤申请 API 密钥:

- 选择支持 OpenAI 兼容 API 的提供商(例如,DeepSeek 或 Grok)。

- 在提供商的平台上注册。

- 在账户设置中生成 API 密钥。

- 根据需要更新您的 API 端点和模型设置。

有关更多信息,请参阅提供商的官方 API 文档。

本地 RAG 搜索

对于需要数据隐私或离线 AI 功能的优异用户和企业,Qsirch 提供由本地托管 LLM 驱动的本地 RAG 搜索。此模式在您的 NAS 或连接的硬件上运行,不会将数据发送到外部服务。

注意

此功能仅在特定 NAS 型号上可用。详情请参阅 QNAP 网站上的

RAG 搜索介绍。

启用本地 RAG:

- 确保 LLM 核心已准备好。

- 将 GPU 设置为 Container Station 模式(前往控制台 > 硬件 > 硬件资源 > 资源使用 > Container Station 模式)。

如何在 Qsirch 中使用 RAG 搜索

- 前往设置 > 管理设置 > RAG 搜索。

- 添加一个或多个云服务以使用 RAG 搜索。

(可选)验证您的 API 密钥。这有助于检查 API 密钥是否有效。

从本地服务下载一个或多个端点模型。此功能仅在特定 NAS 型号上可用。

- 添加更多与 OpenAI API 兼容的 AI 模型,包括 GPT 系列、DeepSeek 模型和 Grok 模型。

- 选择您的 RAG 搜索的文件格式。

- 前往 Qsirch 主页并点击 RAG 搜索按钮。

Qsirch RAG 搜索将仅使用“来源”中包含的文件进行数据检索。

检查您想使用的模型,然后开始使用 RAG 搜索。